2. 西北工业大学 计算机学院, 陕西 西安 710072

红外与可见光图像融合技术在军事和民用领域中占有重要地位,如目标检测、监控和情报收集等。其中,可见光图像含有丰富的细节和纹理信息,但易受光线和天气等因素的影响,难以捕捉到场景内的所有信息;红外图像是经红外成像传感器获得的图像,易丢失许多空间细节信息,视觉感受不自然。红外与可见光图像融合的目的是充分利用红外图像和可见光图像的优势,生成1幅含有丰富细节背景和热目标的高质量图像,便于计算机视觉任务[1]。

由于成像机理的不同,同一空间位置的红外和可见光图像的像素强度往往差异很大,为了得到具有良好视觉感知的融合结果,引入多尺度变换(multi-scale transformation, MST)。常用的MST方法包括:Curvelet、Contourlet、DTCWT等,虽然这些方法能将图像分解为低频子带和高频子带,但它们不具有平移不变性,容易造成伪Gibbs现象。非下采样contourlet(non-subsampled contourlet transform, NSCT)的变换过程包括非下采样结构滤波和非下采样方向滤波,且它们相互独立,这样能更好地保持图像的边缘信息和轮廓结构,增强图像的平移不变性。因此,许多学者将NSCT变换应用到红外与可见光图像融合中,取得了较好的融合效果[2-5]。例如,Wu等[2]充分利用了NSCT灵活的多分辨率和多向性,以及PCNN的全局耦合和脉冲同步激励特性,有效地将红外图像的特征与可见光图像的纹理细节相结合;Wang等[3]从NSCT分解的近似子带中提取亮/暗图像特征,将提取的亮图像特征和暗图像特征与基于不同尺度局部能量图的最大选择规则进行融合。Zhao等[4]通过灰度能量差异性提取红外图像中的目标特征,再应用NSCT对红外图像和可见光图像进行高低频的分解,将灰度能量差异图作为融合权重对红外图像和可见光图像的低频部分进行融合, 对于高频部分采用加权方差的规则进行融合;Zhang等[5]采用NSCT将源图像分解为低频子带和高频子带,分别采用能量和与直觉模糊熵作为低频子带和高频子带的融合规则。

虽然NSCT变换增强了图像的平移不变性,但在融合过程中未考虑空间一致性,容易引起亮度失真。随着机器学习的发展,稀疏表示具有良好的去噪能力和空间一致性等特征,因此基于稀疏表示的图像融合方法已成为主流方法之一。其中,潜在低秩表示(latent low-rank representation, LatLRR)具有较好的空间一致性,已有学者将其应用到红外与可见光图像融合中,并取得较好的融合结果[6-8]。

通过上述分析可知,NSCT变换能较好地保留了图像的边缘信息和轮廓结构,LatLRR方法能更好地平滑图像纹理信息。因此,本文综合NSCT和LatLRR的优势,提出了基于复合分解与直觉模糊集的红外与可见光图像融合方法。实验结果表明,本文融合方法在主、客观评价中都有较好的性能。

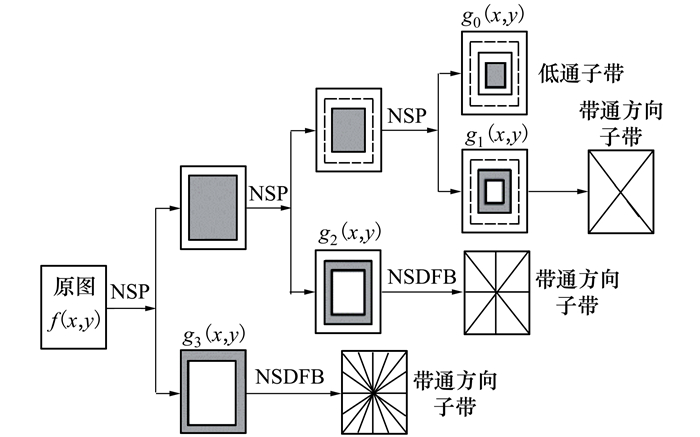

1 相关理论 1.1 图像NSCT分解NSCT是由非下采样方向滤波器组(NSDFB)和非下采样塔式结构滤波器组(NSP)组成的,图 1给出了NSCT变换的结构图。

|

| 图 1 NSCT变换三级分解结构图 |

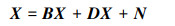

LatLRR方法[9-10]具有较好的空间一致性,能有效提取原始数据中的全局结构和局部结构。它将图像分解为基础子带与显著子带,其表达式为

|

式中:X是输入图像;B是基础系数;D是显著系数;XB, DX分别表示基础子带和显著子带;N表示稀疏噪声。

将LatLRR问题进行最优化求解, 其表达式为

|

|

式中:‖·‖*表示核范数;‖·‖1表示l1范数;α>0表示平衡系数。为便于分析, 令基础子带

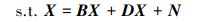

设红外图像I与可见光图像V融合后的图像为F, 图 2给出了本文融合算法。

|

| 图 2 本文融合方法的流程图 |

其中, ①表示NSCT分解方法; ②表示LatLRR方法; ③表示绝对值最大运算; ④表示以视觉显著度为权重的加权融合规则; ⑤表示基于局部梯度幅值和拉普拉斯能量和的直觉模糊数, 并以直觉模糊熵的最大选择为融合规则; ⑥表示NSCT的逆运算。

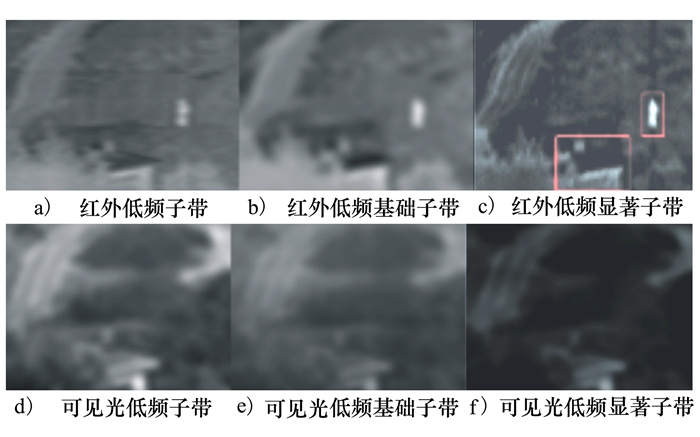

2.1 低频子带的融合规则低频子带包含了大量的图像基本信息, 通过分解低频子带挖掘更多的有用信息, 能有效进行低频子带融合。本文通过LatLRR方法提取低频子带的基础信息和显著信息。图 3是“Camp”红外低频图像的LatLRR分解示意图, 其中λ=0.8。

|

| 图 3 低频图层的LatLRR分解图示 |

由图 3可以看出: 采用LatLRR方法将低频子带分解为低频基础子带和低频显著子带, 挖掘更多子带信息, 其不足之处在于红外目标不显著。

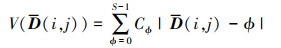

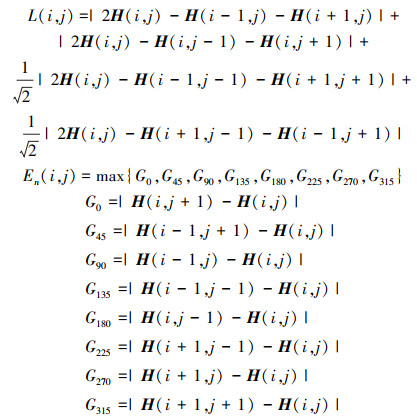

视觉显著图(visual saliency map, VSM)[11]不仅能够捕捉显著性目标、突出显著性区域, 而且能够忽略噪声。因此, 计算低频显著子带的视觉显著图, 即

|

(1) |

式中:

|

| 图 4 低频显著子带和视觉显著图 |

由图 4可以看出, 经V获得的视觉显著图特征提取效果更好, 红外目标更加突出。

融合图像的低频子带LF融合公式为

|

式中,

直觉模糊集(intuitionistic fuzzy set, IFS)可以表示“非此非彼”的中立状态, 在刻画事物的模糊性时更准确。如何确定融合区域隶属于红外区域还是可见光区域显然是一个模糊问题。因此, 许多学者将直觉模糊集应用到图像融合方法中, 并取得了较好的融合效果[5, 12-14]。但这些融合方法均是通过图像灰度值定义隶属度, 而高频子带主要描述源图像的结构信息和纹理信息。

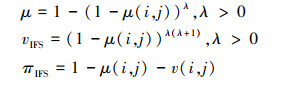

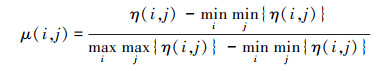

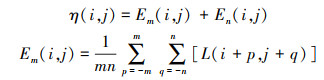

因此, 结合局部梯度幅值En和拉普拉斯能量和Em, 本文定义高频子带的隶属度μ、非隶属度vIFS和犹豫度πIFS分别为

|

式中

|

|

这里

|

式中, H(i, j)表示源图像的高频子带。

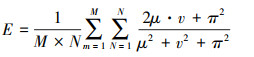

模糊熵是模糊集合论中的一个重要概念。模糊熵越大, 模糊集包含的信息量越多。其局部模糊熵描述如下

|

融合图像的高频子带HF融合公式为

|

式中:HI, HV分别表示红外源图像和可见光源图像的高频子带; EI, EV分别表示红外和可见光源图像的局部模糊熵。

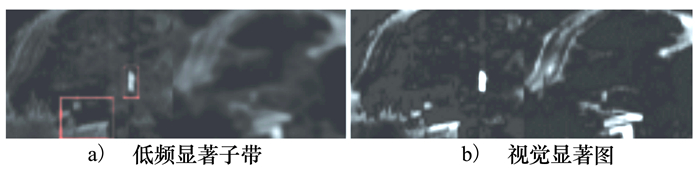

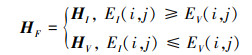

3 实验及结果分析在本节中, 通过主、客观评价多组融合图像的效果, 分析本文融合方法的有效性。其中, 5组红外与可见光源图像对分别是“Road”、“Camp”、“Kaptein”、“UNcamp”和“Leaves”, 它们均来自于TNO Image Fusion Dataset; 采用的融合方法包括: Curvelet、DTCWT、LatLRR[6]、GCF [15]和本文方法。其中, Curvelet和DTCWT分别采用5层和4层分解, DTCWT滤波器参数为“legall”、“qshift-06”; LatLRR方法中设置参数α=0.8;本文融合方法的参数设置为: NSCT分解级数为4级, 滤波器参数为‘pyrexc’和‘vk’, 分解方向数为[2 3 3 4];图像块大小为3×3;α=0.8, λ=10。多种方法的融合结果如图 5所示, 其中, 图 5a)为红外源图像、图 5b)为可见光源图像、图 5c)~5g)分别为Curvelet、DTCWT、LatLRR、GCF和本文融合方法。

|

| 图 5 源图像及多种融合结果示意图(从左至右依次为Road, Camp, Kaptein, UNcamp, Leaves) |

对比Road组融合结果可以看出,基于Curvelet方法和DTCWT方法的融合结果存在明显的光晕,例如行人、红绿灯等,整体视觉效果较模糊;在基于LatLRR的融合结果中,行人存在很明显的伪Gibbs效应,整幅图像较为模糊;在基于GCF的融合结果中,能够看出广告牌上的字较为模糊;基于本文方法的融合结果不仅保留了可见光场景的细节信息,且行人、车辆、红绿灯等红外热目标边缘清晰,接近自然场景。

对比Camp组的融合结果可以看出,在基于Curvelet、DTCWT和LatLRR方法的融合结果中,左右两侧树的辨识度相对较低,尤其是基于LatLRR融合结果中树的纹理几乎看不清;在基于Curvelet和DTCWT的融合结果中,行人周围存在明显光晕;虽然基于GCF的融合结果优于上述3种融合方法,但该方法保留了过多红外信息,房顶处可见光信息几乎全部丢失。基于本文融合方法的融合结果较好地保留了可见光图像的丰富场景信息,也突出了红外图像的热目标信息,尤其能较明显地看出树杈的纹理信息。

本文融合方法的优势同样体现在Kaptein组、Uncamp组和Leaves组的融合图像中。例如,在Kaptein组中,本文方法较好地保留了地面、左侧草丛等纹理信息,行人周围没有明显的光晕现象;在Uncamp组中,在本文方法的融合结果中,“人”在结果图像中对比度适中,灯光等背景细节信息清晰;在Leaves组中,基于本文方法融合结果的目标板更接近红外源图像,目标板与周围细节信息更丰富。总体来说,在视觉质量上,本文融合方法较优于其他图像融合方法。

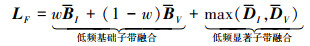

3.2 融合图像的客观评价为了更加客观地评价本文融合方法的有效性,应用边缘信息传递量QAB|F[16]、结构相似度SSIM[17]、特征相似度FSIM[18]和归一化互信息NMI[19]分别从边缘信息保留程度、结构相似度、特征相似度和信息相关程度评价融合图像质量。这4个指标数值越大,则融合效果越好。图 6给出了多组融合图像的客观评价指标值。

|

| 图 6 多组融合图像客观评价指标值 |

由图 6可知,对于QAB|F, 本文融合方法均优于其他融合方法(见图 6a)),表明本文融合方法很好地保留更多的边缘信息;对于SSIM,本文融合方法在Road、Camp、Uncamp和Leaves图像融合效果评价值最优,但在Kaptein融合图像上本文融合方法次之(见图 6b)),表明了本文融合方法较好地保持源图像的结构信息;对于FSIM,本文融合方法在Road、Camp、Kaptein和Uncamp融合图像上对应的评价值最优,而在Leaves融合图像上本文融合方法次之(见图 6c)),表明了本文融合方法较好地保持源图像的特征信息;对于NMI,本文融合方法均优于其他融合方法(见图 6d)),表明了本文融合方法很好地保留源图像的信息。从整体上,本文融合方法较其他融合方法具有更好的融合效果。

4 结论本文结合NSCT和LatLRR的优势,将源图像分解为低频基础子带、低频显著子带和高频子带,分别以加权和法、绝对值最大法、基于局部梯度幅值和区域拉普拉斯能量和的直觉模糊熵选择最大为融合规则,最后通过NSCT逆变换获得融合图像。通过对多组融合结果的主、客观评价,分析了本文方法是切实可行的,能够得到具有丰富信息且较为清晰的融合图像,在视觉质量和客观评价方法较优于其他图像融合方法。

| [1] | ZHU Z Q, CHAI Y, YIN H P, et al. A novel dictionary learning approach for multi-modality medical image fusion[J]. Neurocomputing, 2016, 214: 471-482. DOI:10.1016/j.neucom.2016.06.036 |

| [2] | WU Chunming, CHEN Long. Infrared and visible image fusion method of dual NSCT and PCNN[J]. PLOS ONE, 2020, 15(9): 1-15. |

| [3] | WANG Zhishe, XU Jiawei, JIANG Xiaolin, et al. Infrared and visible image fusion via hybrid decomposition of NSCT and morphological sequential toggle operator[J]. Optik, 2020, 201: 163497. DOI:10.1016/j.ijleo.2019.163497 |

| [4] | ZHAO Changli, ZHANG Baohui, WU Jie, et al. Fusion of infrared and visible images based on gray energy difference[J]. Infrared Technology, 2020, 42(8): 775-782. DOI:10.3724/SP.J.7102614861 |

| [5] | ZHANG Kang, HUANG Yongdong, YUAN Xia, et al. Infrared and visible image fusion based on intuitionistic fuzzy sets[J]. Infrared Physics & Technology, 2020, 105: 1-7. |

| [6] | YU Shen, CHEN Xiaopeng. Infrared and visible image fusion based on a latent low-rank representation nested with multiscale geometric transform[J]. IEEE Access, 2020, 8: 110214-110226. DOI:10.1109/ACCESS.2020.3001974 |

| [7] | JIANG Zetao, JIANG Qi, HUANG Yongsong, et al. Infrared and low-light-level visible light enhancement image fusion method based on latent low-rank represent and composite filtering[J]. Acta Photonica Sinica, 2020, 49(4): 0410001. DOI:10.3788/gzxb20204904.0410001 |

| [8] | WANG X Z, YIN J, ZHANG K, et al. Infrared weak-small targets fusion based on latent low-rank representation and DWT[J]. IEEE Access, 2019, 7: 112681-112692. DOI:10.1109/ACCESS.2019.2934523 |

| [9] | LIU G C, LIN Z C, YU Y. Robust subspace segmentation by low-rank representation[C]//Proceedings of the 27th International Conference on Machine Learning, Haifa, Israel, 2010: 663-670 |

| [10] | LIU Guangcan, YAN Shuicheng. Latent low-rank representation for subspace segmentation and feature extraction[C]//IEEE International Conference on Computer Vision, Barcelona, Spain, 2011: 1615-1622 |

| [11] | MA J, ZHOU Z, WANG B, et al. Infrared and visible image fusion based on visual saliency map and weighted least square optimization[J]. Infrared Physics & Technology, 2017, 82: 8-17. |

| [12] | JIANG Zetao, HE Yuting, ZHANG Shaoqin. Infrared and Low-light-level visible image fusion algorithm based on contrast enhancement and Cauchy fuzzy function[J]. Acta Photonica Sinica, 2019, 48(6): 0610001. DOI:10.3788/gzxb20194806.0610001 |

| [13] | ZHANG Xuefeng, YAN Hui, HE Hao. Multi-focus image fusion based on fractional-order derivative and intuitionistic fuzzy sets[J]. Front Inform Technol Electron Eng, 2020, 21(6): 834-843. DOI:10.1631/FITEE.1900737 |

| [14] | BALASUBRAMANIAM P, ANANTHI V P. Image fusion using intuitionistic fuzzy sets[J]. Information Fusion, 2014, 20: 21-30. DOI:10.1016/j.inffus.2013.10.011 |

| [15] | WEI Tan, ZHOU Huixin, SONG Jiangluqi, et al. Infrared and visible image perceptive fusion through multi-level Gaussian curvature filtering image decomposition[J]. Applied Optics, 2019, 58(12): 3064-3073. DOI:10.1364/AO.58.003064 |

| [16] | XYDEAS C S, PETROVIC V. Objective image fusion performance measure[J]. Electronics Letters, 2000, 36(4): 308-309. DOI:10.1049/el:20000267 |

| [17] | MA K, ZENG K, WANG Z. Perceptual quality assessment for multi-exposure image fusion[J]. IEEE Trans on Image Processing, 2015, 24(11): 3345-3356. DOI:10.1109/TIP.2015.2442920 |

| [18] | ZHANG Lin, ZHANG Lei, MOU Xuanqin, et al. FSIM: a feature similarity index for image quality assessment[J]. IEEE Trans on Image Processing, 2011, 20(8): 2378-2386. DOI:10.1109/TIP.2011.2109730 |

| [19] | AKTAR M, MAMUN M A, HOSSAIN M A, et al. Weighted normalized mutual information based change detection in remote sensing images[C]//19th International Conference on Computer and Information Technology, Dhaka, 2016: 257-260 |

2. School of Computer Science, Northwestern Polytechnical University, Xi'an 710072, China