2. 东莞市三航军民融合创新研究院, 广东 东莞 523808

装配是产品生命周期中的一个重要环节,产品的装配时间和装配质量直接影响着产品的开发成本和使用性能。在当今中国制造业中手工装配仍占据着重要地位[1-2],其费用高昂且属于产品研制工作的后端,提高装配效率和可靠性所带来的经济效益远比简单地降低零件生产成本所带来的经济效益显著[3]。

在手工装配中经常会遇到一些盲区手工装配的情况,所谓的盲区手工装配是指在装配过程中的人手、目标位置、手持零部件或手持工具等出现在盲区或者狭窄区域中,使得装配过程的必要视觉信息丢失,从而对装配过程造成困难,甚至难以进行。对于这种特殊情况,装配工人在作业过程中需要不断调整身体姿态,才能部分地看到装配部位,导致装配效率低、错误率高、工人容易疲劳等,甚至是无法进行装配。Boothroyd等[4]通过研究表明装配过程中存在工件被遮挡的情况,被遮挡的程度越大装配难度越大。此外,Jovanovic等[5]通过研究表明,装配过程中的身体姿态越复杂装配难度越大。

增强现实(augmented reality, AR)技术具有同时展现真实世界信息和虚拟世界信息的能力,能够将计算机生成的装配引导信息(如三维模型、装配动画、文本提示等)在装配现场中“无缝”叠加,能大大提高装配操作效率和质量[6],在解决上述问题中具有很大的潜力。

为了在装配现场中"无缝"叠加虚拟装配引导信息,需要对虚拟信息进行三维注册。三维注册技术是虚实融合效果的基本要求,实现三维注册的关键为摄像机定位追踪。早期的增强现实所采用的摄像机追踪算法都是基于人工标志点的,最具代表性的为美国华盛顿大学HIT实验室开发的ARToolkit[7],通过图形处理找到标识物的角点像素坐标及标识物的世界坐标,利用PnP[8-9]算法求解相机位姿。由加拿大研究院开发的ARTag[10]使用了一种边缘启发式搜索算法,用来降低标识识别的误检率,使其在具有一定抗遮挡能力的同时,具有较低的姿态估计误差及内部编码率。基于人工标志点的摄像机追踪算法具有算法复杂度低、追踪稳定性强、追踪精度高、漂移小等特点,在增强现实装配领域,机械产品追踪精度要求高[11],因此基于人工标志点的摄像机追踪方法具有显著优势。

增强现实可视化方式除了传统的PC显示外,其他显示方式概括起来有3大类:①手持式显示;②HMD(head mount display)显示;③投影显示[12]。手持式显示主要指手机平板等移动式显示设备,但显示方式并不直观;HMD增强现实显示主要缺点是长时间穿戴会不舒适;基于投影的显示通常不需要用户穿戴或者携带任何设备。Bimber等[13]采用几何变形、辐射补偿、多焦点投影和多投影仪共同投影的技术实现了在普通平面上产生立体投影的效果。由于操作者更喜欢在无负载的情况下工作,因此基于投影的显示在机械装配领域内有更大的应用。

在增强现实辅助装配领域,哥伦比亚大学的Henderson和Feiner[14]开发了一个面向狭小空间的增强现实辅助装配系统,实验人员佩戴AR眼镜,通过文本、标签、箭头和动画的引导在狭窄的炮塔内安装紧固件、指示灯以及线缆等零件,实验结果表明在狭小空间内使用增强现实系统辅助装配时可以减少操作人员头部的移动次数。

受Feiner等工作的启发,王增磊等[15]对手工装配中遇到的盲区问题,利用增强现实技术将盲区信息直观呈现给工人。该方法根据待装配对象可见部分的大小使用HTC vive的2个手柄或通过leap motion对手的追踪间接估计待装配对象位姿,并利用vive头盔显示增强现实场景和装配体模型。这种方法很大程度上解决了盲区不可见部分的装配难题,但是基于传感器的追踪方法极易受到外部环境的干扰,导致模型抖动或丢失,因此,很难适用于高精度的装配场景。此外,调研发现工人在制造现场作业时不喜欢佩戴头盔,这会给工作带来诸多不便,如增加工作负荷等。

本文在前述研究的基础上提出一种精确、鲁棒基于机器视觉的定位追踪方法,并将该方法应用于盲区装配,同时借助局部误差放大的原理进行AR可视化引导装配,从而期望提高装配精度和装配效率,降低装配错误率、缓解工人身心疲劳。

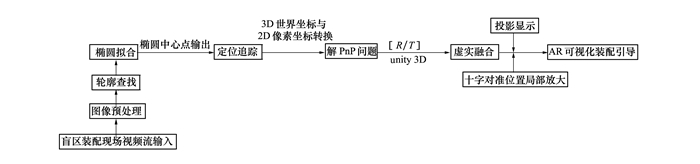

1 系统概要基于机器视觉的增强现实盲区装配方法基于机器视觉的增强现实盲区装配总体工作流程如图 1所示,总共包括3个部分:①标志点椭圆的识别和检测;②盲区对象的定位追踪;③盲区装配信息的AR可视化。在开始阶段,使用相机采集盲区装配现场的图像,通过图像预处理降低图像噪声,采用轮廓查找、椭圆拟合等方式识别标志点椭圆,由于标志点贴在盲区待装配对象的外表面,所以通过对椭圆的定位追踪就可以实现盲区待装配对象的定位追踪,并通过解PnP问题,实现椭圆中心点3D世界坐标与2D像素坐标的转换,从而求得相机的位姿(R/T),将位姿信息传入unity3D中,与unity3D中的模型实现虚实结合。最后根据虚实结合注册的结果,将装配引导信息通过投影的方式在装配环境中叠加,同时借助局部误差放大的原理进行AR可视化引导装配。

|

| 图 1 盲区装配总体工作流程图 |

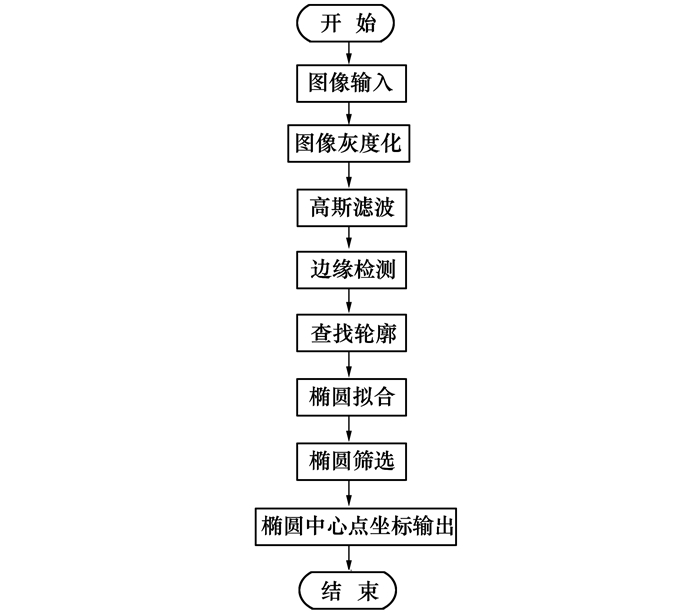

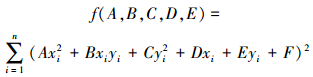

识别和检测椭圆标志点是为了实时定位追踪与标志点绑定的盲区待装配对象,本文椭圆标志点的识别和检测技术流程如图 2所示。

|

| 图 2 椭圆识别检测流程 |

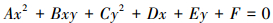

由于受光照、环境等众多因素的影响,相机采集的图像总是会存在许多噪声,而这些噪声会对检测识别椭圆带来一定影响,因此采集到原始图像后,需要对这些图像进行图像预处理,以有效降低由于噪声和失真变形对后续识别算法造成的干扰。首先对原始图像灰度化处理后进行高斯滤波,然后采用Hough PV所提出的最大类间方差法[16](OTSU)图像二值化处理,再利用canny边缘检测算子提取二值图像中的有效边缘轮廓,得到的边界轮廓上的像素点集并不是完整的轮廓曲线,因此再对使用链表结构形式储存的轮廓信息进行遍历筛选,经筛选处理得到完整的二维轮廓曲线。为了提高椭圆检测精度,需要将椭圆识别实现亚像素精度定位,为此对已查找到的轮廓边缘像素点集,通过使用最小二乘法[17]进行椭圆拟合,从而计算出椭圆中心点的亚像素精度坐标位置。椭圆的一般方程为

|

(1) |

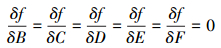

运用最小二乘法进行椭圆拟合, 即最小化轮廓边缘像素点集与拟合椭圆之间的距离度量。距离度量指的是平面内一点(x0, y0)到椭圆方程f(x, y)=0所代表的代数距离即f(x0, y0)。为了避免方程零解, 令A+C=1, 设查找到的某个轮廓边缘像素点集为Pi(x, y), 包含的像素点个数为n, 运用最小二乘法计算方程(1)的系数, 使得函数

|

(2) |

最小。根据极值定理, 当f(A, B, C, D, E)最小时, 满足

|

(3) |

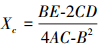

根据上述等式得到的线性方程组, 以及约束条件A+C=1, 就可以计算得到方程系数A, B, C, D, E, F的值。则椭圆中心坐标Pc(Xc, Yc)为

|

(4) |

|

(5) |

椭圆拟合完成后, 为了减小图像中出现的干扰椭圆点, 根据椭圆面积和长度进行筛选, 精确找到目标标志点椭圆, 并输出椭圆中心点坐标。

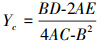

1.2 盲区对象的定位追踪对盲区对象的追踪是通过将椭圆标志点粘贴在盲区对象表面, 通过追踪椭圆的方式间接追踪盲区待装配对象。为了确定椭圆粘贴表面的位姿, 首先需要标定相机, 获得相机的内参矩阵Mc、相机内参畸变参数矩阵等, 然后通过解PnP问题, 确定相机在真实世界坐标系下的坐标(3D)与像素坐标下的坐标(2D)之间的转换关系。PnP问题是求解3D-2D点对运动的方法, 描述了当知道n个三维空间点坐标及其二维投影位置时, 如何估计相机的位姿。在1幅图像中, 最少只要知道3个点的空间坐标即3D坐标, 就可以用于估计相机的运动以及相机的姿态。而特征点的空间世界坐标, 可以通过深度图来确定, 亦可在初始化时, 通过设定世界坐标系的方法解得, 由于本文使用单目相机, 因此通过设计1个大椭圆、3个小椭圆标志点以椭圆所在平面为世界坐标XY平面, 并以大椭圆标志点中心坐标作为原点确定世界坐标系(Z坐标设为0), 并按照顺时针方向逐个确定3个小椭圆的世界坐标, 又通过椭圆检测可以确定对应的椭圆中心点像素坐标, 因此通过公式

|

(6) |

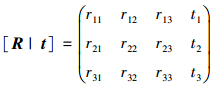

可以确定矩阵[R| t], 其中R是旋转矩阵, t是位移向量。在(6)式中

|

(7) |

相机的内参矩阵为

|

(8) |

求得矩阵[R | t]后, 就可以完成从世界坐标系到相机坐标系的转换。如果世界坐标系为X, 相机坐标系对应坐标为X ′, 那么X′=[R | t]· X。从相机坐标系到理想像素坐标系的变换就需要内参数矩阵Mc。那么理想像素坐标系L = Mc·[R | t]· X。

在知道真实世界坐标系与像素坐标系的转换关系后, 可以获得椭圆标志点所在的平面的位置和姿态, 在unity3D虚拟世界中, 通过给虚拟“十字”模型赋值的方式, 使“十字”模型位于虚拟相机坐标系下4个椭圆的正中心之间的位置, 通过实时追踪椭圆标志点, 无论怎么移动和旋转待装配对象, 十字模型也会随椭圆标志点所在的平面移动和旋转, 与椭圆的相对位置始终保持不变。

1.3 盲区装配信息的AR可视化在unity3D虚拟世界中, 通过将“十字”模型叠加到视频流中装配体表面, 可以实现“十字”模型随装配体移动而移动, 为了在真实世界中实现盲区装配, 需要将unity3D中的装配信息进行AR可视化处理, 从而实现操作者在信息的引导下有效地完成盲区的装配。

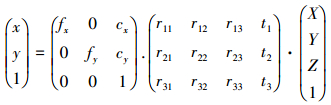

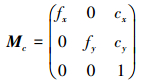

本文通过采用投影的方式实现盲区装配信息的可视化处理, 首先通过投影一个浅色的“十字”到盲区装配的装配体的准确装配位置, 然后通过追踪待装配体的位姿, 使与装配表面相对位置始终不变的深色“十字”与浅色“十字”准确对齐, 这样操作者就可以有效地完成盲区装配。为了实现深色“十字”准确投影到带装配体表面, 需要将投影仪、相机进行联合标定确定投影仪的外参, 设相机的单应性矩阵为Hcs, 投影仪的单应性矩阵为Hps, 则相机与投影仪之间的单应性矩阵为Hcp= Hcs· Hps-1。在unity3D中, 设置2个虚拟相机, 1个代表相机, 1个代表投影仪, 根据相机与投影仪之间的转换关系, 将深色“十字”模型的坐标从相机坐标系转换到投影仪像素坐标系下, 这样投影出来时就能保证深色“十字”刚好投影到4个标志点椭圆的中心。为了在最后装配“十字”对齐时降低操作者的难度和提高位置精度, 本文根据局部误差放大原理, 将窗口进行局部放大, 示意图如图 3所示, 这样操作者就能根据引导信息更精确操作, 不至于出现“十字”无法对齐的情况。

|

| 图 3 投影位置局部放大示意图 |

系统的软件架构主要由四部分构成, 即服务器与客户端的通信和数据共享、基于人工标识的定位追踪算法、盲区的可视化与装配引导信息的虚实融合以及相机投影仪对的标定。整个架构基于unity3D和visual studio(C/C++)开发, 通过把基于人工标识的定位追踪信息以DLL的形式嵌入到unity3D的工程中, 并以投影仪的形式实现AR可视化装配引导。

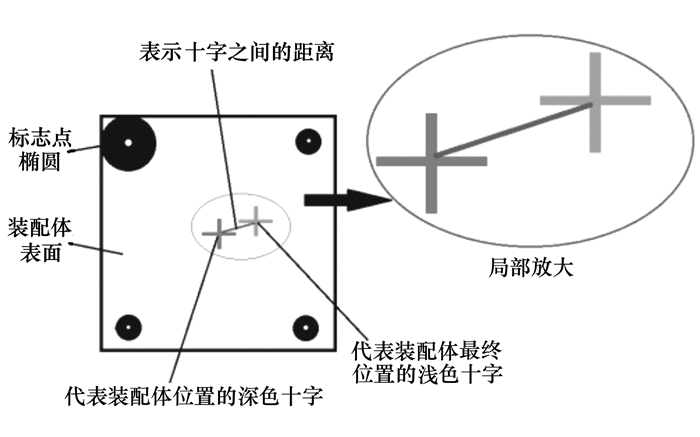

为验证该方法对盲区装配的影响, 设计了1套盲区装配硬件系统。如图 4所示, 系统由投影仪、USB相机、上下接插件以及运行程序的服务器组成。在实验的过程中需要将上接插件底部的针脚准确插入到下接插件内部对应的针孔里, 针脚和针孔模型示意图如图 5所示。由于针脚被固定在一个较大的形体底面, 因此在整个装配过程中针孔和针脚完全被形体所遮挡, 实际装配过程中只能通过经验以及不断试探, 才能完成工作。

|

| 图 4 系统硬件图 |

|

| 图 5 针脚和针孔模型示意图 |

本实验中共有20人参与实验, 17位男性, 3位女性, 所有人都有AR/VR方面的实验经验。实验中, 参与者分别在有AR引导下进行装配和无AR引导下进行装配, 因此本用户研究实验为组内设计。为了平衡学习效应的影响, 打乱相邻2组的参与者参与实验的条件顺序, 如:前面一组先做有AR引导的盲区装配, 后做无AR引导的盲区装配, 后面一组参与实验的条件顺序正好相反。

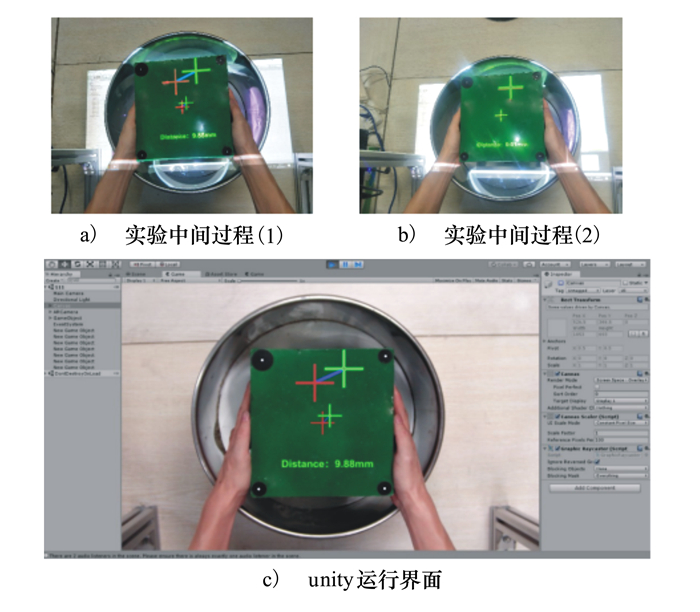

有AR引导的盲区装配实验场景如图 6所示。实验开始时, 实验工作人员开始计时, 参与者从固定位置拿起上接插件, 移动上接插件将红色十字架对准绿色十字架(见图 6a)), 当2个十字架之间的距离接近于零时注意观察距离偏差放大图(见图 6b)), 直到二者之间的距离为零时平稳地将上接插件的针脚准确插到下接插件的针孔里, 完成装配后结束计时同时记录是否装配正确, unity3D中的运行界面如图 6c)所示。

|

| 图 6 AR引导盲区装配实验场景 |

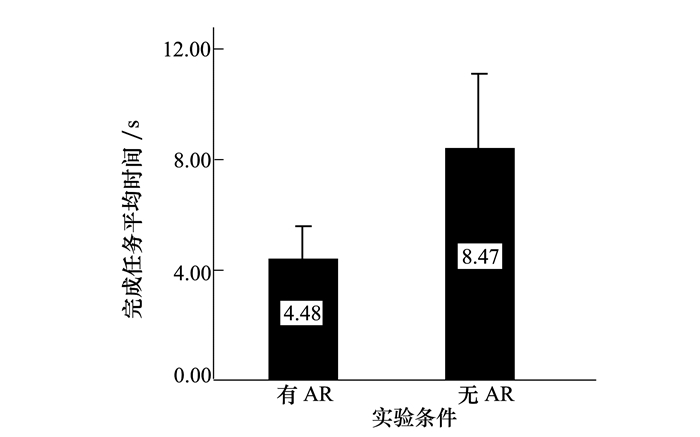

本节中通过装配完成的时间间接衡量装配效率, 时间越短, 则说明效率越高, 反之。同时, 对装配过程中的错误率进行了统计。由于本章实验设计是采用组内实验设计, 因此对时间变量和错误率进行配对样本T检验。最后, 对问卷结果进行分析。

2.3.1 装配完成时间如图 7所示, 有AR引导的盲区装配平均时间(4.48±1.21 s)与无AR引导的盲区装配平均时间(8.47±2.75 s)相比有显著的差异。

|

| 图 7 装配完成时间 |

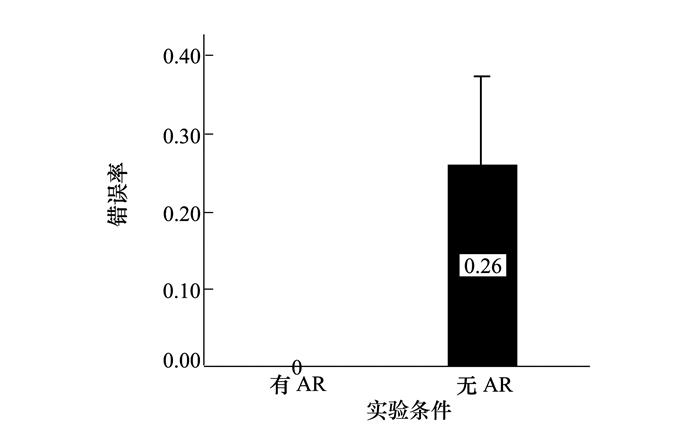

对于装配错误率采用公式(9)计算

|

(9) |

如图 8所示, 有增强现实辅助下的装配错误率(0.00±0.00)与无增强现实辅助下的装配错误率(0.26±0.12, p < 0.05)相比有显著性差异。

|

| 图 8 装配错误率 |

本文针对手工装配中的盲区装配作业难题, 提出了一种基于增强现实的盲区装配方法。该方式首先利用基于机器视觉的定位追踪方法对待装配零件进行定位追踪, 然后利用误差放大的AR可视化效果进行引导装配, 最后设计并实施了基于增强现实的盲区装配实验, 对装配效率及错误率进行评估。实验结果表明本文方法能显著提高盲区装配作业的效率, 并能有效降低装配错误率。

| [1] | RADKOWSKI R. Augmented Reality-Based Manual Assembly Support with Visual Features for Different Degrees of Difficulty[J]. International Journal of Human-Computer Interaction, 2015, 31(5): 337-349. DOI:10.1080/10447318.2014.994194 |

| [2] | BOOTHROYD G. Product Design for Manufacture and Assembly[J]. Computer-Aided Design, Elsevier, 1994, 26(7): 505-520. DOI:10.1016/0010-4485(94)90082-5 |

| [3] |

刘检华. 军工数字化装配技术[J]. 国防制造技术, 2011(4): 5-7.

LIU Jianhua. Digital Assembly Technology in Military Industry[J]. Defense Manufacturing Technology, 2011(4): 5-7. (in Chinese) |

| [4] | BOOTHROYD G. Product Design for Manufacture and Assembly[J]. Computer Aided Design, 1994, 26(7): 505-520. DOI:10.1016/0010-4485(94)90082-5 |

| [5] | JOVANOVIC V. Ergonomic Design of Manual Assembly Workplaces[C]//Annual ASEE IL/IN Section Conference, 2007 |

| [6] |

王月, 张树生, 白晓亮. 点云和视觉特征融合的增强现实装配系统三维跟踪注册方法[J]. 西北工业大学学报, 2019, 37(1): 143-151.

WANG Yue, ZHANG Shusheng, BAI Xiaoliang. A 3D Tracking and Registration Method Based on Point Cloud and Visual Features for Augmented Reality Aided Assembly System[J]. Journal of Northwestern Polytechnical University, 2019, 37(1): 143-151. (in Chinese) |

| [7] | KATO H, BILLINGHURST M. Marker Tracking and HMD Calibration for a Video Based Augmented Reality Conferencing System[C]//Procedings of the 2nd IEEE and ACM International Workshop on Augmented Reality, 1999 |

| [8] | MORENO-NOGUER F, LEPETIT V, FUA P. Accurate Non-Iterative O(n) Solution to the PnP Problem[C]//IEEE International Conference on Computer Vision, 2007: 1-8 |

| [9] | LEPETIT V, MORENO-NOGUER F, FUA P. EPnP:an Accurate O(n) Solution to the PnP Problem[J]. International Journal of Computer Vision, 2009, 81(2): 155-166. |

| [10] | FIALA M. ARTAG, a Fiducial Marker System Using Digital Techniques[C]//IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2005: 590-596 |

| [11] | WANG X, ONG S K, NEE A Y C. A Comprehensive Survey of Augmented Reality Assembly Research[J]. Advances in Manufacturing, 2016, 4(1): 1-22. |

| [12] | ZHOU F, DUH H-L B M. Trends in Augmented Reality Tracking, Interaction and Display: a Review of ten Years in ISMAR[C]//Proceedings from ISMAR 7th IEEE/ACM International Symposium: Mixed and Augmented Reality, 2008: 193-202 |

| [13] | BIMBER O. Enabling View-Dependent Stereoscopic Projection in Real Environments[C]//Proceedings of the Fourth IEEE and ACM International Symposium on Mixed and Augmented Reality, 2005: 14-23 |

| [14] | HENDERSON S, FEINER S. Exploring the Benefits of Augmented Reality Documentation for Maintenance and Repair[J]. IEEE Trans on Visualization and Computer Graphics, 2011, 17(10): 1355-1368. DOI:10.1109/TVCG.2010.245 |

| [15] |

王增磊, 张树生, 白晓亮. 基于增强现实的产品盲区装配技术研究[J]. 制造业自动化, 2019, 41(1): 29-35.

WANG Zenglei, ZHANG Shusheng, BAI Xiaoliang. Augmented Reality Based Product Blind Area Assembly Assistance[J]. Manufacturing Automation, 2019, 41(1): 29-35. (in Chinese) |

| [16] | OHTSU N. A Threshold Selection Method from Gray-Level Histograms[J]. IEEE Trans on Man Cybernetics, 1979, 9(1): 62-66. |

| [17] |

闫蓓, 王斌, 李媛. 基于最小二乘法的椭圆拟合改进算法[J]. 北京航空航天大学学报, 2008, 34(3): 295-298.

YAN Bei, WANG Bin, LI Yuan. Optimal Ellipse Fitting Method Based on Least-Square Principle[J]. Journal of Beijing University of Aeronautics and Astronautics, 2008, 34(3): 295-298. (in Chinese) |

2. Dongguan Sanhang Civil-Military Integration Innovation Institute, Dongguan 523808, China