2. 中国船舶工业系统工程研究院, 北京 100036

长期以来,为了提高水下目标识别的正确率,研究人员从不同的角度对水下目标辐射噪声原始信号进行了分析和研究,提取了水下目标的时域波形特征、频域分析特征、时频分析特征和听觉特征。将所提取的高维特征简单组合作为识别特征有可能引起维数灾难,以及可能加入噪声特征,使得水下目标识别系统识别精度下降。为了解决此类问题,人们研究了水下目标特征选择方法,这些方法主要有:遗传算法、人工免疫算法、粗集理论、向前向后搜索算法、支持向量机集成和特征选择联合算法等[1, 2, 3, 4]。其中,遗传算法和人工免疫算法理论上可以搜索全局最优解,但是遗传算法随机性大且运行速度过慢。人工免疫算法相比遗传算法可利用先验知识及免疫算子提高运行速度和收敛速度,但运算量仍然过大。粗集理论、向前向后搜索算法本质上是顺序搜索算法,容易丢掉最优解,结果不令人满意。支持向量机集成和特征选择联合算法将分类器设计和特征选择融合在一个框架之中,在减少特征数目同时,提高了识别正确率,但是融合效率、计算速度以及相关参数的确定,还需进一步深入研究。而且上述方法在特征评价过程中没有考虑特征之间分类信息互补。

本文提出了联合互信息水下目标特征选择算法(joint mutual information feature selection,JMIFS),JMIFS算法基于互信息理论计算特征与类标的相关度,以及对已选特征分类信息的补充量,以此来评价特征组合所持有的分类信息。并将该评价准则融入顺序向前搜索方法,进行最优特征子集搜索。评价准则能够计算特征与类标的相关性和冗余性且独立于后续学习算法,同时利用顺序向前搜索计算快速的特点,达到快速去除噪声特征和冗余特征及提高识别性能的目的。

利用实测水下目标数据进行了识别实验,结果表明该方法能在保证识别正确率基本不变的基础上,显著降低特征数目,以减少后续学习算法的计算代价。相比基于支持向量机和遗传算法的特征选择方法(support vector machine-genetic algorithm,SVM-GA)[4],可用更少的特征表征完全特征集,生成泛化能力更强的模型。

1 用于特征评价的互信息理论特征选择的目标是从原始特征集中选取包含所有特征蕴含的全部或绝大部分信息的特征子集。由于被丢弃的特征几乎是无信息量的,因此学习算法的性能将会很少降低,甚至由于除掉带有干扰信息的特征使得算法性能提高。

信息理论中的互信息是用来评价变量持有信息量的重要方法。2个变量间的互信息是在已知1个变量的情况下,另外1个变量不确定度的减少量,即两者的相关度。用熵表示变量的不确定度,采用概率密度函数p进行熵估计[5]。

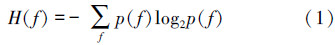

离散特征f的熵H(f):

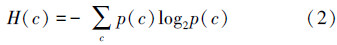

同理,类标c的熵H(c):

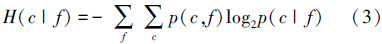

已知特征f时,类标c的不确定度用条件熵H(c|f)度量:

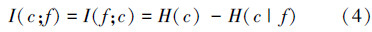

设特征f与类标c的互信息为I(c;f),即信息增益。信息增益取值越大表示特征与类标的相关度越强,也就是特征包含的分类信息越多。

条件互信息表示已知1个或多个变量的情况下,另外2个变量的相关程度。条件互信息定义为:

公式(5)表示在已知特征g的条件下,特征f与类标c的相关度,即特征f所包含的特征g所没有的分类信息,若该条件互信息较大,说明特征f对特征g有较大的分类信息补充量[6, 7]。

信息增益是机器学习领域广泛使用的一种特征评价方法。但是,其仅仅考虑特征与类标的相关度,没有考虑特征与特征间的互补关系,也无法从原理上去除冗余特征。本文考虑引入条件互信息对特征空间进一步压缩。

2 JMIFS算法JMIFS算法原理如下:首先计算并选择信息增益最大的特征;然后在选择下一个特征时,根据信息增益和分类信息的补充量来评价特征的优劣,利用顺序向前搜索方法,逐个递增地选取特征,组成优化特征子集。

设特征全集U={f1,f2,…,fn}由n个特征f组成,优化特征子集S={g1,g2,…,gk},其中g为从U中选择的特征,k为需要的特征个数,k≤n。

首先,选择U中与类标c具有最大互信息量的特征,作为特征集S的第1个特征g1

式中,fi∈U。然后,依次选择特征集U中的特征作为特征集S的第q个特征gq,q=2,3,…,k。公式(7)的第1项评价出信息增益较大的特征。若该特征与特征集S中的特征冗余,则已选特征条件下该特征的分类信息较少。因此,第2项评价出拥有特征集S所不包含的信息,并且分类信息较大的特征,即与特征集S分类信息互补的特征。

式中,fi∈U,gj∈S。下面给出了JMIFS算法流程:

输入:特征全集U={f1,f2,…,fn}

S=Φ,需要的特征数k

输出:优化特征子集S={g1,g2,…,gk}

① f∈U 计算I(c;f)

f∈U 计算I(c;f)

根据公式(6)得到g1

S={g1},U=U\f②  f∈U,g∈S计算I(f;c|g)

f∈U,g∈S计算I(f;c|g)

根据公式(7)、(8)得到gq

S=SU{gq},U=U\f

重复②直到|S|=k

3 实验与讨论 3.1 实验数据本文所用的实测水下目标分为4类,每类480个样本,样本总数为1 920。每个样本提取71维多域特征,分别是波形结构特征,小波分析特征,听觉谱特征,Mel频率倒谱特征。该特征集具有连续特征空间,首先对其离散化处理,便于进行互信息估计。本文采用有监督1R离散化方法[9]。

3.2 特征选择前后分类性能对比采用如下2种方式比较在使用JMIFS方法特征选择前后特征子集的分类性能,①支持向量机(support vector machine,SVM)的分类结果;②样本在空间的分布。

3.2.1 SVM分类结果对比将全部71维特征与用JMIFS算法得到9维优化特征子集分别作为SVM分类器的输入,采用2折交叉验证的方法,对4类水下目标进行分类,结果如表 1所示,在分类精度下降很小的情况下,优化特征子集可以大幅减少分类时间。

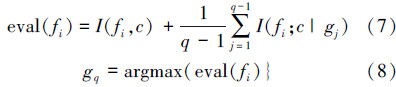

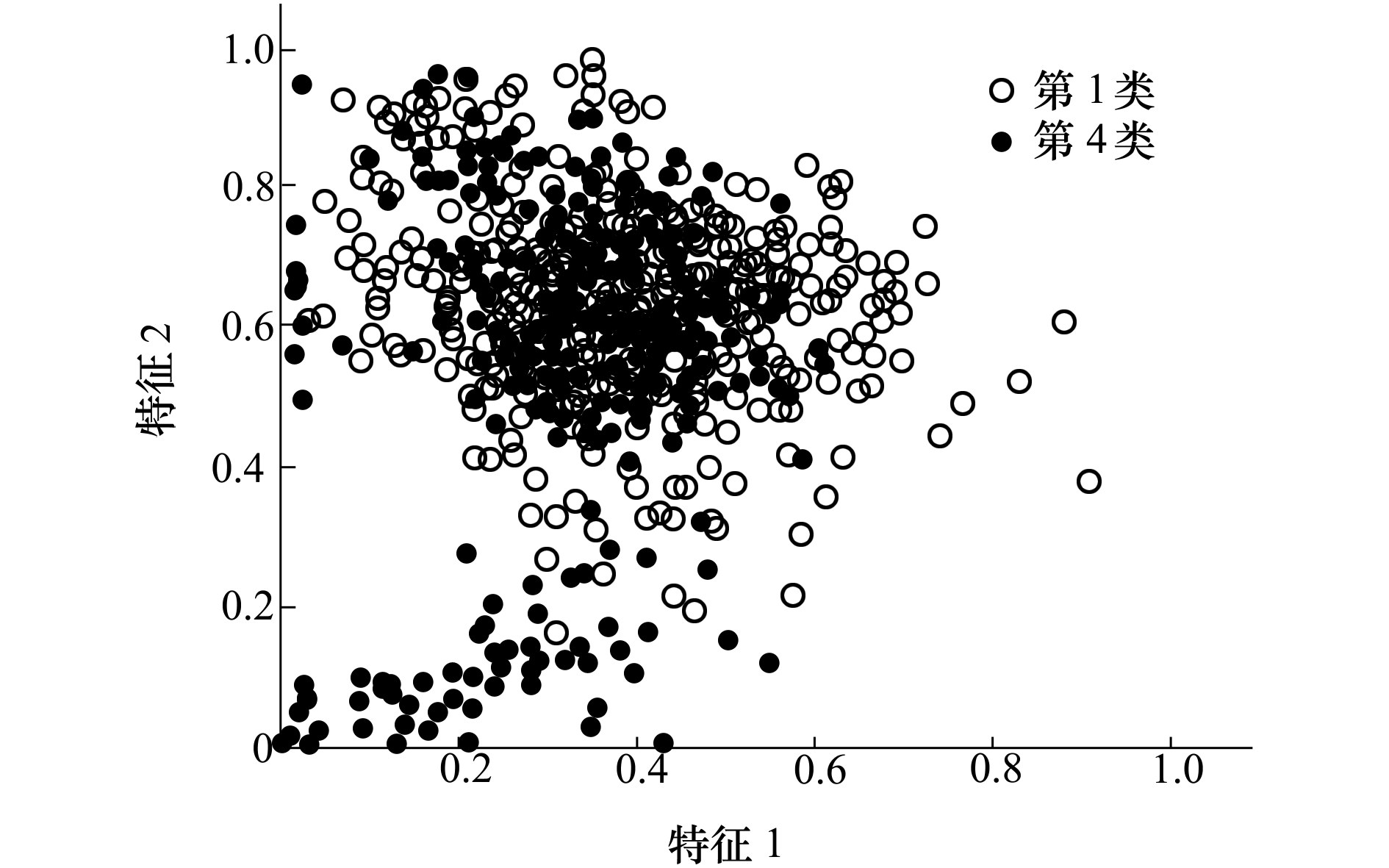

使用JMIFS方法选择出最佳两维特征(记为特征1和特征2)和最差两维特征(记为特征3和特征4),分别在二维平面绘制第1类样本与第4类样本的空间分布图,如图 1和图 2所示,对比可以看出,最佳两维特征的1、4类样本分布于不同的区域,有较好的分类能力;而最差两维特征的1、4类样本混在一起,分类能力较差。

|

| 图 1 最佳两维特征1、4类样本空间分布 |

|

| 图 2 最差两维特征1、4类样本空间分布 |

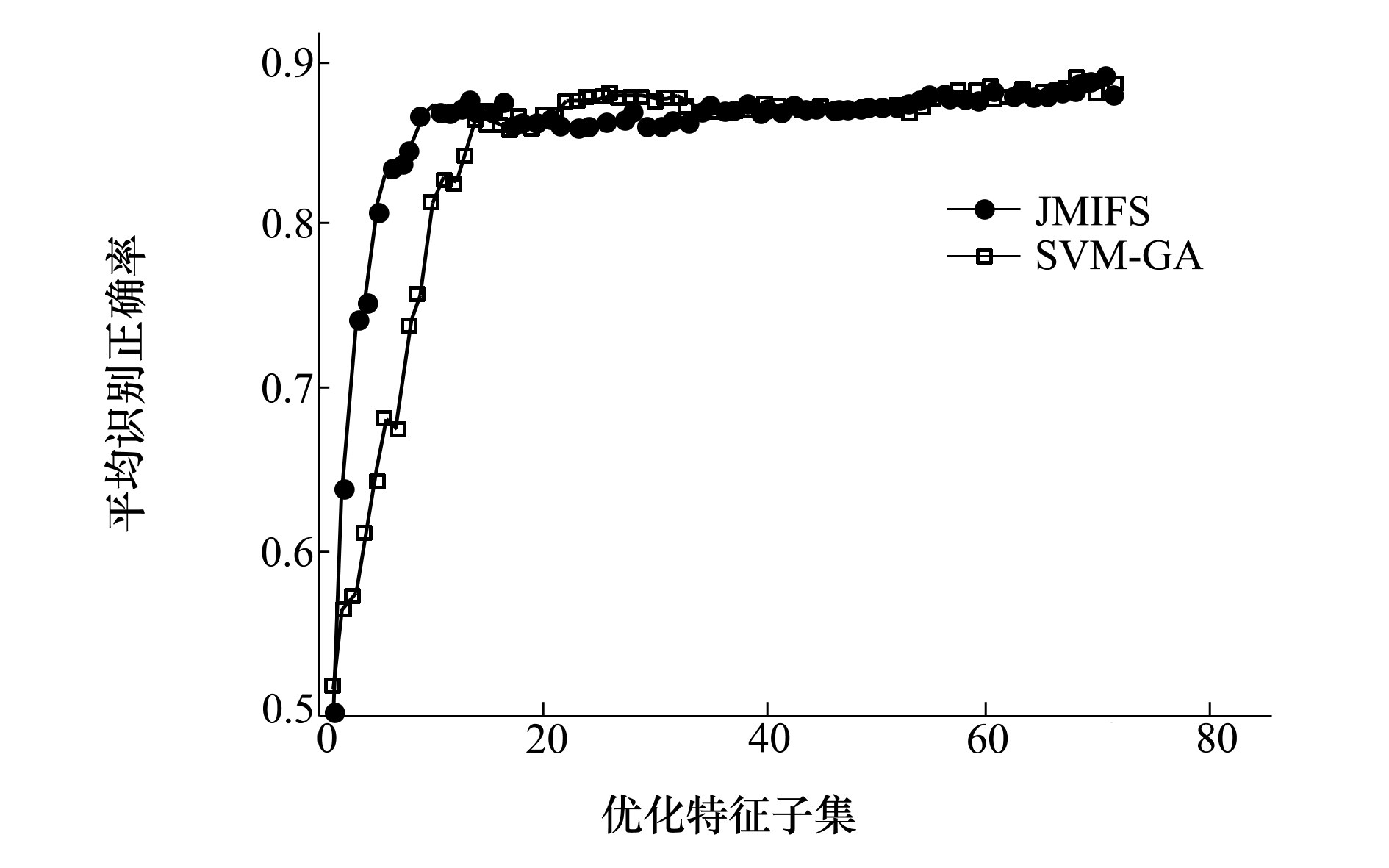

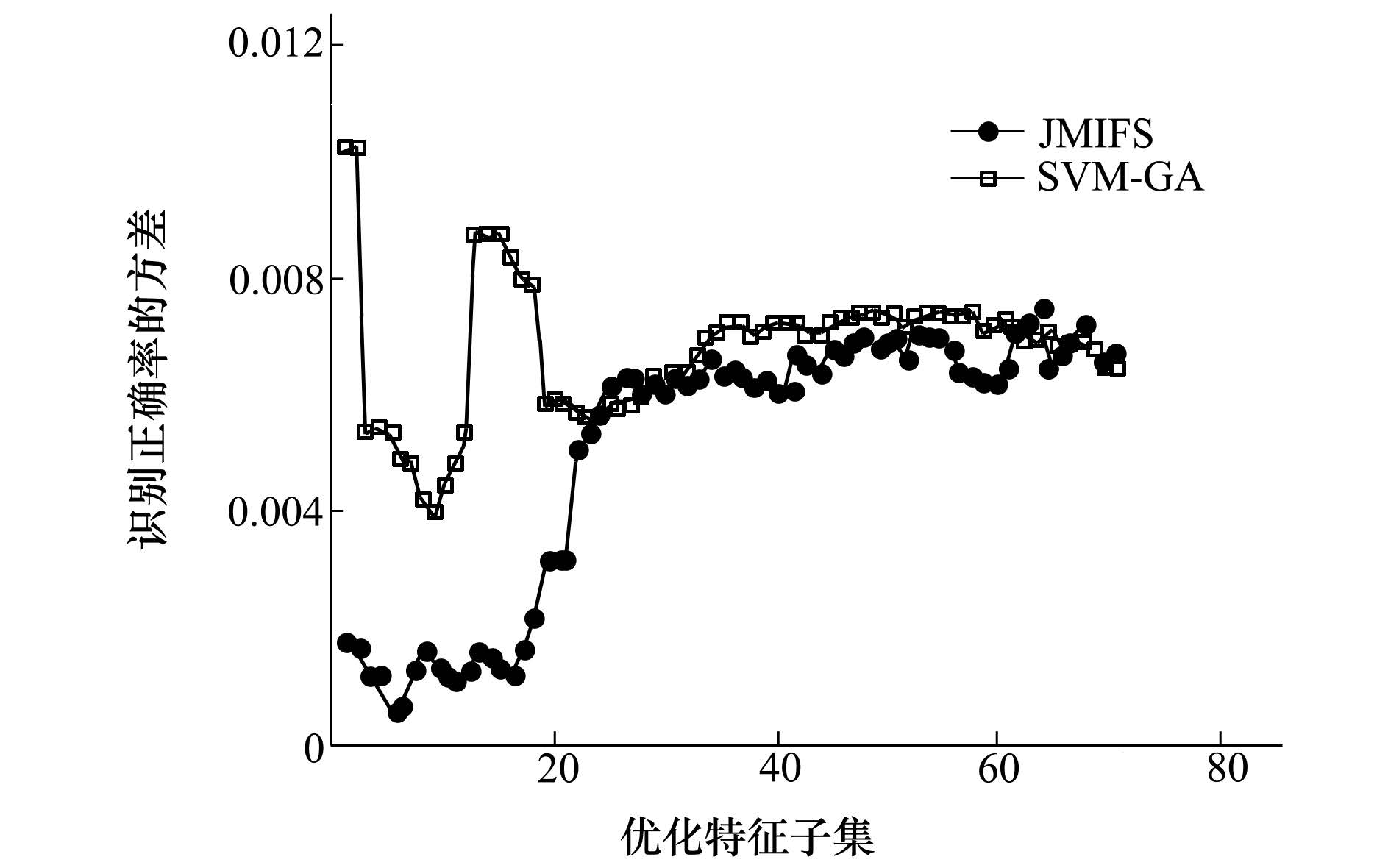

分别用JMIFS和SVM-GA进行特征选择实验,比较2种算法输出特征子集的SVM的识别正确率和识别正确率的方差。

使用JMIFS对71维特征排序,依据特征在输出列表中的位置,逐个递增地选取特征,组成特征子集,并作为SVM分类器的输入进行分类实验。对于SVM-GA方法,将GA运行K代,记录每代的最佳个体,按照特征在全部K代最佳个体中的选择次数降序排列,以同样的方式产生特征子集,作为SVM分类器的输入。采用10次10折交叉验证运行结果的平均识别正确率和识别正确率的方差来评估特征选择结果的优劣,结果如图 3和图 4所示。

|

| 图 3 平均识别正确率 |

|

| 图 4 识别正确率的方差 |

由图 3可知,当特征维数低于15维时,JMIFS选出的特征子集比SVM-GA选出的特征子集识别正确率高。使用JMIFS进行特征选择,当特征子集维数大于9维时,支持向量机的识别正确率与全部71维特征下识别正确率相当,因此可用更小的特征子集来表征全部特征集。

从图 4可以看出,在特征子集维数低于25维时,使用相同维数的特征子集,JMIFS比SVM-GA选出的特征子集在SVM上识别正确率的方差小,说明JMIFS选出的特征子集具有更好的泛化能力和更好的稳健性;结合图 3,当优化特征子集维数高于15维时,识别正确率基本保持不变,但是方差却逐渐增大,说明JMIFS方法能有效去除冗余特征。

以上的实验结论均说明,这种将联合互信息特征评价方法融入顺序向前搜索策略的特征选择方法,能有效地选择水下目标优化特征子集,在一定程度上解决水下目标识别的问题。

4 结论本文提出的联合互信息水下目标特征选择算法(JMIFS),依次评价特征与类标的相关性和特征对已选特征的互补性,采用顺序向前搜索策略,达到快速去除噪声特征和冗余特征的目的。采用本文算法对实测水下目标数据进行特征选择和分类实验,结果表明,JMIFS算法在保持识别正确率很少下降的情况下,可显著降低特征维数,有效降低分类时间,并且有较好的泛化性能。

| [1] | 杨宏晖, 王芸, 孙进才, 等. 融合样本选择与特征选择的AdaBoost支持向量机集成算法[J]. 西安交通大学学报, 2014, 48(12):63-68 Yang Honghui, Wang Yun, Sun Jincai, et al. An AdaBoost Support Vector Machine Ensemble Method with Integration of Instance Selection and Feature Selection[J]. Journal of Xi'an Jiaotong University, 2014, 48(12):63-68 ( in Chinese) |

| Cited By in Cnki | |

| [2] | 王磊, 彭圆, 林正青, 等. 听觉外周计算模型在水中目标分类识别中的应用[J]. 电子学报, 2012, 40(1) : 199-203 Wang Lei, Peng Yuan, Lin Zhengqing, et al. The Application of Computational Auditory Peripheral Model in Underwater Target Classification[J]. Acta Electronica Sinica, 2012, 40(1) : 199-203 ( in Chinese) |

| Cited By in Cnki (8) | Click to display the text | |

| [3] | Peng Yuan. A Study on Several Feature Selection Methods in Target Classification and Recognition[C]//IEEE Computer Science and Automation Engineering, Shanghai, 2011 : 736-739 |

| Click to display the text | |

| [4] | 杨宏晖, 孙进才, 袁骏.基于支持向量机和遗传算法的水下目标特征选择算法[J]. 西北工业大学学报, 2005, 23(4):512-515 Yang Honghui, Sun Jincai, Yuan Jun. A New Method for Feature Selection for Underwater Acoustic Targets[J]. Journal of Northwestern Polytechnical University. 2005, 23(4):512-515 ( in Chinese) |

| Cited By in Cnki (27) | Click to display the text | |

| [5] | Cover T M, Thomas J A. Elements of Information Theory[M]. New Jersey: John Wiley & Sons, 2012 |

| [6] | Peng H, Long F, Ding C. Feature Selection Based on Mutual Information Criteria of Max-Dependency, Max-Relevance, and Min-Redundancy[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2005, 27(8): 1226-1238 |

| Click to display the text | |

| [7] | Kumar G, Kumar K. A Novel Evaluation Function for Feature Selection Based Upon Information Theory[C]//Electrical and Computer Engineering (CCECE), Canada, 2011: 000395-000399 |

| Click to display the text |

2. Systems Engineering Research Institute, Beijing 100036, China