装配是产品生命周期中的一个重要环节, 产品的装配时间和装配质量直接影响着产品的开发成本和使用性能。据统计, 在现代制造过程中, 装配工作量占整个产品研制工作量的20%~70%, 平均为45%, 装配时间占整个制造时间的40%~60%。同时, 产品装配通常以手工作业为主, 费用高昂且属于产品研制工作的后端, 提高装配效率和可靠性所带来的经济效益远比简单地降低零件生产成本所带来的经济效益显著[1]。

由于增强现实(AR)技术具有同时展现真实世界信息和虚拟世界信息的能力, 能够将计算机生成的装配引导信息(如三维模型、装配动画、文本提示等)在装配现场中“无缝”叠加, 能大大提高装配操作效率和质量。因此, 近年来AR技术被越来越多地应用到机械产品装配过程, 基于AR技术的装配辅助系统层出不穷。其中, 精确的三维跟踪注册是AR装配辅助系统的核心技术之一, 它是实现虚拟装配提示信息在装配环境中准确叠加的关键。经过近几年的发展, 三维跟踪注册已经取得了重大进步, 但仍然存在着不同程度的缺陷:基于自然特征点的方法[2-3]在表面缺少足够纹理特征的环境中容易出现跟踪注册抖动或扰动。基于边缘轮廓的方法[4-5]对杂乱的背景比较敏感, 且对于装配交互过程中造成的目标物体部分遮挡不鲁棒。基于模型的方法[6-8]需要对从不同视角采集到的大量参考视图进行处理, 这会导致巨大的搜索空间和庞大的运算量, 大大降低了系统的实时性和可用性。基于即时定位与地图构建(SLAM)[9-11]方法的三维跟踪注册不需要场景的先验知识, 免去了复杂的训练过程。但它们仅能估计出相机的相对位姿, 对于需要绝对位置信息的装配场景不能直接适用, 而且这些方法在动态场景中容易造成跟踪注册失败。基于稠密点云的三维跟踪注册方法[12-13]能在光照强度较低且表面缺少纹理的机械装配环境中表现出较好的鲁棒性。该类方法运用ICP(iterative closest point)配准算法对全部或部分点云进行迭代运算, 降低了对光照条件的要求, 同时提高了传感器位姿估计精度。但是这类方法与SLAM方法相同, 也仅能估计传感器的相对位姿。而且当深度传感器快速移动, 导致无法获取正确的初始对应数据点集时, ICP算法迭代过程容易陷入局部最优, 难以保证收敛速度和配准精度, 甚至造成“丢帧”的情况, 使跟踪注册过程中断。同时, 跟踪注册过程采用连续帧间配准会随着传感器运动距离的增大, 跟踪注册精度大幅降低。

本文提出了一种精确、鲁棒的无标识三维跟踪注册方法。首先以ICP点云配准为基础, 利用参考模型点云对三维跟踪注册绝对坐标系进行定义。然后结合彩色图像信息, 将视觉特征匹配点对作为ICP迭代过程的初始对应数据点集。为了在光滑、无纹理的装配环境中获取足够数量的视觉特征匹配点对, 提出一种基于方向向量一致性的视觉特征匹配策略, 从而提高了装配环境中的跟踪注册算法精确性和鲁棒性。

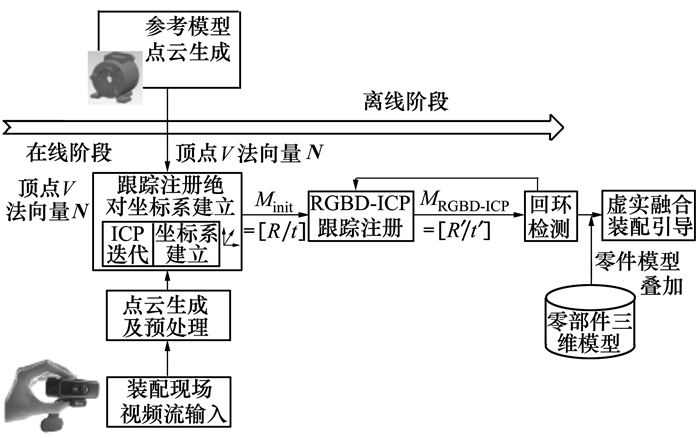

1 系统概况算法基本思想和工作流程如图 1所示。在离线阶段, 将参考CAD模型生成三维参考点云模型, 为跟踪注册绝对坐标系的建立做准备。在在线阶段, 采集三维装配环境点云, 利用点云配准计算参考模型点云和装配环境中物理对象表面点云之间的变换关系, 完成绝对坐标系的定义。然后采用RGBD-ICP配准对跟踪注册过程相机位姿进行估计, 并利用回环检测对估计位姿进行优化。最后根据三维跟踪注册结果, 将装配引导信息在装配环境中叠加, 实现装配过程的可视化引导。

|

| 图 1 算法思想和工作流程 |

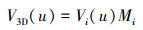

首先采用WJBF方法(weighted joint bilateral filter)[14]对装配环境深度图像进行降噪修复。然后将降噪后深度图像中i时刻的每一个像素点u=(x, y), 利用NVIDIA公司的CUDA并行计算平台反投影到深度相机空间坐标系, 获得顶点(vertex map), 反投影结果为

|

(1) |

式中, Di(u)为i时刻的深度图像, Mint-D为深度相机内部参数。

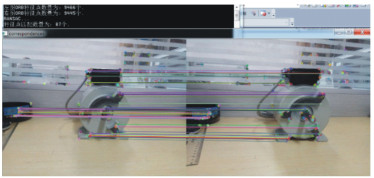

在时刻i的6DOF相机位姿用矩阵Mi=[Ri|ti]表示, 其中Ri为3×3的旋转矩阵, ti为三维平移向量。通过6DOF相机位姿, 可将(1)式转换到全局坐标空间

|

(2) |

同时, 每个顶点对应的法向量N3D(u)用相邻投影点通过作如下运算得

|

(3) |

将(3)归一化到单位长度N3D/‖N3D‖2。归一化后的单位法向量N3D(u)和三维顶点V3D(u)构成三维装配环境点云。

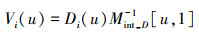

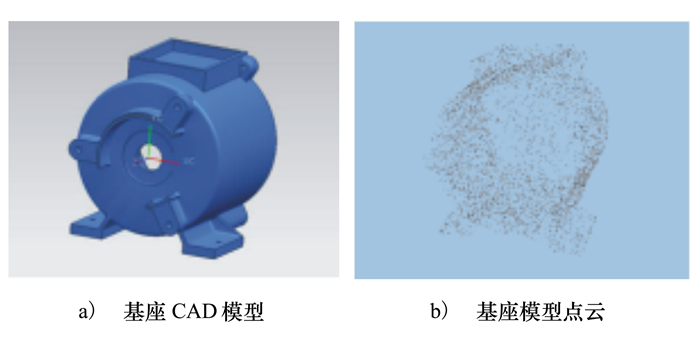

1.2 三维跟踪注册绝对坐标系建立将参考对象三维模型在CAD环境中生成点云Pi={p0, p1, p2…pm, n0, n1, n2…nm}, 其中p0, p1, …pm为模型表面顶点坐标, n0, n1, …nm为顶点对应的法向量。以水泵AR装配引导为例, 将基座三维模型作为参考对象, 生成点云, 获得表面顶点个数5 558, 法向量数为5 078(见图 2)。

|

| 图 2 基座模型点云生成 |

在线装配过程中, 首先将t时刻降噪修复后的装配现场深度图像Rt(u), 利用1.1节方法生成三维环境点云X, 其中X={x0, x1, x2…xn, N0, N1, N2…Nn}。然后采用ICP算法, 将三维环境点云X与参考模型点云Pi={p0, p1, p2…pm, n0, n1, n2…nm}进行配准。配准过程使用欧氏距离作为度量, 同时引入法向量特征作为额外限制条件, 以尽量减少误匹配点数目。法向量之间的相似性用点积dij=〈Ni, nj〉进行表示, 假如dij大于某一阈值ψ, 则认为是对应点, 并赋予权值1, 表示为

|

(4) |

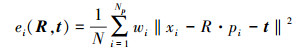

通过采用欧式距离和法向量特征度量方法, 便可获得对应点的个数N及每一对对应点的权值wi。采用最小二乘法对迭代过程中位置关系误差矩阵进行求解, 其中误差关系矩阵为

|

(5) |

通过旋转矩阵R和平移向量t的求解, 便可获得基座参考模型点云和真实基座点云重合时的变换关系:

|

(6) |

假设参考对象模型坐标系原点即为相机坐标系原点, 所以通过变换关系Minit的求解即可获得相机在参考模型坐标系(即装配坐标系)下的初始位姿。在上述计算过程中采用了大量点云数据参与计算, 虽然保证了始位姿矩阵的计算精度, 但同时大大增加了时间消耗。因此, 本文仅采用此步骤进行相机位姿的初始化, 初始化完成后的相机位姿将采用连续视频帧间ICP点云配准的方法进行计算, 后文将详细进行介绍。

1.3 视觉特征提取与匹配连续视频帧间ICP点云配准是三维跟踪注册中常用的方法。它主要分为2步:第一步确定对应数据点集, 第二步根据对应点集求解点云数据间的变换关系。但是现有方法在相机突然发生快速移动时, ICP配准算法由于无法获取前后2帧点云数据间的初始对应关系, 使计算出的相机位姿不准确, 甚至造成跟踪注册失败。考虑到Softkinetic彩色图像数据和深度图像数据存在一一对应的关系, 可将点云的初始匹配问题转化为彩色图像特征点的匹配问题。利用匹配的视觉特征点对作为初始对应点集, 是解决连续视频帧间ICP点云配准的有效方法。

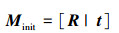

目前很多局部特征如SIFT、SURF、ORB、BRISK、FREAK等被广泛应用于图像匹配、物体识别等领域。基于特征点匹配的快速性和稳定性的考虑, 本文选用ORB局部特征。ORB局部特征采用FAST作为特征点检测子, 改进的BRIEF作为特征描述子, 采用BF(brute force)模式匹配算法进行特征描述符匹配, 该算法对具有丰富纹理的物体图像匹配表现出良好的性能。但是由于机械装配环境中零部件表面光滑, 原始ORB匹配过程难以获得足够数量的匹配点对, 且特征点比较集中, 不利于保证旋转平移矩阵计算的可靠性。图 3为采用原始ORB进行特征提取与匹配的结果。从图中可以看出, 原始ORB匹配可以提取到足够数量的特征点, 但是匹配点对较少, 且其中的误匹配较多, 常采用随机抽样一致性检测(RANSAC)算法进行误匹配点剔除。图 4为原始ORB特征匹配采用RANSAC后最终只能获得87个匹配点对, 匹配点对数量进一步降低, 难以满足ICP初始配准需求。

|

| 图 3 原始ORB特征提取与匹配 |

|

| 图 4 原始ORB特征提取与匹配+RANSAC外点消除 |

为了能获取足够数量的正确ORB特征点对作为初始匹配数据点集, 本文受基于网格的运动统计(GMS)[15]方法思想启发——运动平滑一致性的匹配点不大可能是随机出现的, 匹配点对真假的判别可以通过周围匹配点的简单计数来实现。基于上述思想对OBR特征匹配过程进行改进, 本文称为OGMS, 算法思想基于如下假设:

假设 正确匹配点对周围邻域内的匹配点对应该具有相同的单位方向向量(见图 5)。

|

| 图 5 基于方向向量一致性的特征点匹配假设示意图 |

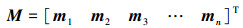

设M为某一正确匹配点对邻域内匹配点对连线单位方向向量构成的矩阵为

|

(7) |

方向向量mi与mj的相似性用点积dij表示

|

(8) |

方向向量mi(1×2)与匹配点对矩阵M2×nT中各方向向量的相似度用G表示

|

(9) |

将G中所有元素按降序排列, 若G中某一元素小于阈值δ(实际运算过程取0.985), 说明所对应的匹配点对的连线方向偏离大部分匹配点对的连线方向, 该匹配点对被作为误匹配而被剔除, 并采用GMS中的网格划分进行匹配过程中的加速。

采用上述改进后的ORB进行特征匹配结果如图 6所示。通过改进的ORB对装配环境两相邻视频帧进行特征提取与匹配, 正确匹配点数目由原来的87变为3 478, 且该过程耗时较少。

|

| 图 6 基于方向向量一致性的ORB特征匹配 |

受SIFT-ICP算法的启发[16], 利用改进的ORB特征点匹配, 对ICP点云配准, 即传感器位姿估计过程进行优化。首先从装配环境2幅相邻视频帧彩色图像中分别提取稀疏ORB视觉特征集合Fa, Fb, 通过改进的ORB匹配获得特征点匹配点对集合Cs, Ct。因为ORB特征是在图像上提取的, 说明在二维空间特征向量存在相似性, 但是这并不能说明在三维空间仍然是匹配点对。因此本文首先通过2帧图像对应的深度图像利用Softkinetic的内部参数将匹配点对Cs, Ct映射到三维空间形成空间点云集合Ps, Pt。然后利用随机抽样一致性(RANSAC)方法将三维误匹配点对剔除, 分别形成内点集合Ps-inliner, Pt-inliner, 同时获得初始点云变换矩阵M'=[R'|t']。然后进入ICP主循环。在第一次迭代中, 通过稀疏ORB匹配特征点对匹配计算出的初始变换阵M'=[R'|t']使没有任何先验位姿知识的相邻2帧间点云实现了最近邻初始配准。然后将点云配准转化为求解点云集合间的误差函数最小化问题。误差函数分为2个部分, 第一部分计算稀疏ORB视觉特征匹配点对之间的平均欧氏距离, 第二部分将当前点云到目标匹配点云切平面(point-to-tangent Plane)的距离作为度量。误差函数用(10)式表示

|

(10) |

式中,M*为位姿矩阵, α为权重值(实际运算过程取0.5), nbj为稠密点云中目标点pbj的法向量, 它是通过其周边邻域点作叉乘获得。

将装配环境数据点云间满足误差函数最小的匹配对作为算法的输入量。不同视角图像间的数据可以看做是多个坐标系间的旋转平移运动, 这样我们每做一次旋转平移运动就会更新一次数据, 通过反复迭代变换矩阵, 更新输入数据, 从而最小化环境点云数据间的偏移误差函数。在点云变换矩阵误差变化小于阈值δ或者达到最大迭代次数, ICP主循环停止迭代, 否则将会利用最近一次计算的变换矩阵进行点云的重新配准, 直到误差满足一定的精度要求。此过程采用kd-tree算法加速最近点搜索, 同时利用图形处理器(GPU)对点云配准过程进行加速运算。

1.5 回环检测与位姿全局优化连续视频帧间配准方法, 适用于短距离的跟踪注册。当相机移动较长距离时, 相机位姿的估计随着移动距离的推移而发生漂移, 特别是返回到以前访问过的位置时, 这种漂移现象最为明显, 这被称为回环问题。为了解决上述问题, 需要回环检测来识别相机是否返回到先前访问过的位置。

本文通过判断图像间的相似性来进行回环检测, 即通过ORB视觉特征匹配来完成。首先构建一个帧间约束的位姿图结构, 它由结点和边组成, 结点表示每个环境图像帧的位姿, 边表示图像帧之间的空间位置关系, 它可以通过RGBD-ICP点云配准方法获得。当闭环不存在时, 位姿图结构就是一个线性链, 当前帧位姿估计误差都会对后续帧产生影响, 相机位姿估计误差较大; 当存在闭环时, 位姿图中就会产生环形结构, 几个相邻帧间多了一些约束, 因而误差降低。

为保证位姿图的稀疏性和回环检测的实时性性, 受文献[17-18]启发, 将关键帧作为结点。关键帧是装配环境图像帧的子集, 其元素个数由装配环境图像帧的密度和装配环境复杂度来决定。本文关键帧的选取依据特征点对数来确定。例如, 将第一帧X1作为关键帧, 采用改进的ORB提取特征点, 与其最近邻图像帧进行匹配并获得当前帧与关键帧之间的变换矩阵。当特征点匹配个数N大于阈值ϕ时, 则不作为下一个关键帧。随着相机的持续移动, 匹配点个数逐渐减少, 将特征点匹配个数N小于阈值ϕ的第一帧作为下一个关键帧。

当新的关键帧X2产生后, 与先前每一个关键帧进行回环检测。为保证检测回环的可靠性, 将匹配点对利用Softkinetic的内部参数和匹配点对计算出的变换矩阵M*=[R*|t*]映射到三维空间, 形成空间点云集合P={pi}, P'={pi'}。当匹配点在三维空间中匹配误差小于阈值ψ时, 可认为闭环产生了, 并在位姿图结构中添加新的边。匹配误差定义为

|

(11) |

检测到回环后, 根据前后帧计算获得的位姿变换可以建立前后帧的位姿约束, 回环检测可以建立回环处的位姿约束, 通过优化这两种约束, 实现前后帧间的位姿约束与回环约束之间的全局一致性。本文采用TORO[16]对其进行后台优化, 寻找达到全局一致性的结点位姿配置, 将累积误差进行均衡处理, 从而优化相机轨迹, 降低相机位姿估计值和真实值的误差, 提高相机位姿MRGBD-ICP=[Rrelat|trelat]的计算精度。

通过相机位姿初始化和RGBD-ICP连续视频帧间配准, 在时刻i的相机全局绝对位姿Mi可用(12)式表示, 其求解过程示意图如图 7所示。

|

(12) |

|

| 图 7 相机绝对位姿计算示意图 |

跟踪注册结果可视化实验验证采用英特尔至强Xeon-E3微处理器, CPU主频为3.5 GHz, 运行内存为8GB, 显卡为NVIDIA Geforce GTX 970。Softkinetic用于深度和彩色信息获取, 其彩色传感器分辨率为1 280×720, 深度传感器分辨率为320×240。为了提高运行速度, 实验中彩色图像大小设置为640×480。软件系统采用“Unity3D”游戏引擎进行开发, 用3D Studio Max进行装配引导信息建模。算法采用C++语言编写, 并以动态链接库(DLL)的形式导入Unity3D。

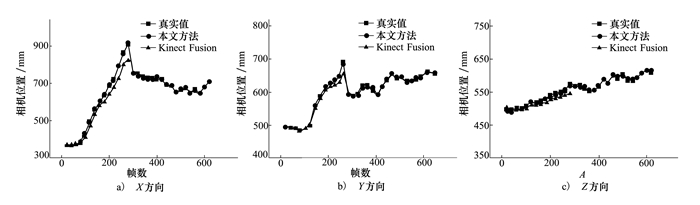

2.1 三维跟踪注册算法精确性测试在水泵装环境中, 将Softkinect深度传感器与虚拟现实跟踪设备HTC Vive手柄(定位精度±1.5 mm)绑定, 并将采集到的HTC Vive手柄运行轨迹作为真实值。同时, 分别采用KinectFusion[19]跟踪注册方法和本文提出的点云和视觉特征融合的跟踪注册方法进行三维注册, 并对Softkinect深度传感器运行轨迹的X, Y, Z 3个分量进行分析。实验对比结果如图 8所示。从图中可以看出, 传统的基于点云的跟踪注册方法(Kinect Fusion)随着相机移动距离的增大, 与真实值误差越来越大, 且在300帧左右跟踪注册过程中断, 这是由于相机移动速度过快, ICP初始对应数据点集获取失败, 导致跟踪注册过程中断。本文方法在跟踪注册过程中加入了视觉特征匹配, 因此能获得相机快速移动前后的变换矩阵, 为后续点云迭代过程提供了正确的初始值, 避免了相机跟踪注册过程的失败。

|

| 图 8 本文方法跟踪轨迹与真实运行轨迹的对比 |

为了更直观地表达采用不同跟踪注册方法的相机位置测量值和真实轨迹之间的误差, 采用公式(13)进行位置误差的度量:

|

(13) |

实验结果如表 1所示。从表中可以看出, 采用本文方法估计的相机轨迹与真实运行轨迹非常接近, 相机测量位置与其真实位置误差较小, 表明本文算法精确性更高。与KinectFusion相比, 本文方法提高了基于稠密点云的跟踪注册准确性和鲁棒性。

| 帧数 | 本文方法 | Kinect Fusion |

| 10 | 6.16 | 10.44 |

| 100 | 10.68 | 101.16 |

| 200 | 12.21 | 205.35 |

| 300 | 12.25 | 311.81 |

| 400 | 9.85 | —— |

| 500 | 9.38 | —— |

| 600 | 11.36 | —— |

本文跟踪注册过程首先需要利用模型点云完成相机位姿初始化(即三维跟踪注册绝对坐标系建立), 该过程耗时较多(~2 s), 但初始化完成后将不再执行此过程, 因此算法执行时间不将其统计在内。初始化完成后系统跟踪注册过程可分为明显的4个阶段:深度图像获取、深度图像降噪修复、点云生成、点云视觉特征融合跟踪注册, 整个过程耗时23.19 ms, 系统运行速度可实现每秒30帧, 满足系统实时性要求。

| 步骤编号 | 执行过程 | 时间/ms |

| 1 | 视频流输入 | 2.86 |

| 2 | 点云生成及预处理 | 13.79 |

| 3 | RGBD-ICP跟踪注册 | 4.04 |

| 4 | 回环检测 | 2.50 |

| 5 | 总时间 | 23.19 |

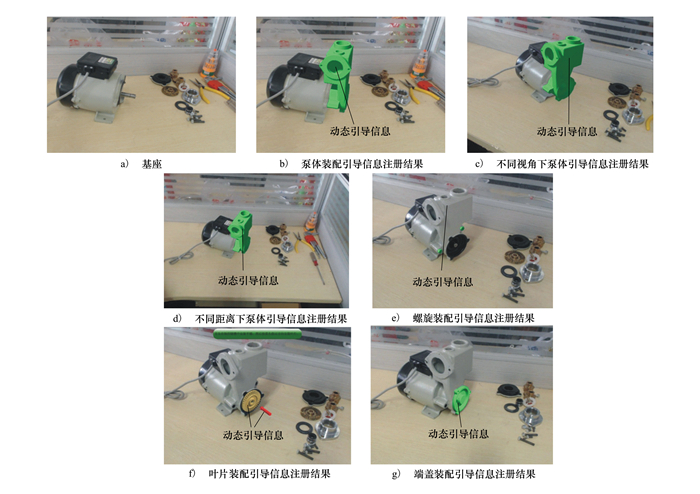

以水泵作为装配目标, 开发了基于AR的装配辅助系统。该系统利用3D Max进行引导信息建模, Unity 3D作为软件开发环境, 本文算法采用C++语言编写, 并以动态链接库(DLL)的形式导入Unity 3D。系统硬件配置及软件架构可参阅本团队前期工作[7, 20]。将水泵基座三维模型在CAD环境中生成点云模型。同时, 为了呈现良好的虚实融合效果, 采用基于模型的方法[21]对装配引导信息和装配体之间的遮挡关系进行处理。实验过程中, 保持泵体不动, 手持Softkinetic进行移动, 获取不同视角、不同距离下的装配引导信息三维注册结果, 实验结果如图 9所示。图 9a)为水泵基座, 实验开始后, 首先获取装配场景深度图像, 生成点云, 并与基座模型点云进行配准, 获取Softkinetic在基座模型坐标系下的位姿。图 9b)为初始化完成后, 将基座模型坐标系原点作为装配基准, 并依据Softkinetic位姿, 将泵体装配引导信息进行叠加。移动SoftKinetic, 改变其与基座的视角和距离, 获取不同视角和不同距离下的引导信息注册结果(见图 9c)~图 9d)), 从图中可以看出, 不同视角、不同距离下本文算法都能达到较好的三维空间注册效果。图 9e)~图 9g)展示了不同装配工序的引导画面, 图中标注所示为动态引导信息, 用于确定待安装工件泵体和螺栓的装配位置。对于关键装配工序的装配方法, 采用文字、箭头指示和动画组合的形式进行引导(见图 9f)), 便于操作人员明晰、无二义性地理解装配指令, 提高装配效率, 降低装配工作出错几率。

|

| 图 9 三维跟踪注册结果可视化 |

本文提出了一种面向AR机械装配辅助系统的三维跟踪注册方法, 该方法首先针对跟踪注册过程中装配场景物体表面光滑、缺少纹理的特点, 提出了一种基于方向向量一致性的视觉特征匹配策略。然后基于ICP点云配准方法, 设计了一种点云和视觉特征匹配相结合的三维跟踪注册方法, 同时加入回环检测和全局优化策略, 既避免了因初始匹配数据点集不足导致的相机跟踪注册失败, 又保证了相机位姿估计精度。最后利用三维跟踪注册矩阵, 完成了基于AR辅助系统的水泵装配引导实验。实验结果表明, 本文方法精确性、实时性好, 能达到每秒30帧。而且在相机快速移动时仍能表现出较好的鲁棒性, 其综合性能优于基于点云的KinectFusion三维跟踪注册方法。

| [1] |

刘检华. 军工数字化装配技术[J]. 国防制造技术, 2011(4): 5-7.

LIU Jianhua. Digital Assembly Technology in Military Industry[J]. Defense Manufacturing Technology, 2011(4): 5-7. (in Chinese) |

| [2] |

肖鸿.面向复杂产品装配现场的移动三维模型关键技术研究[D].西安: 西北工业大学, 2014 XIAO Hong. Research on the Key Technologies of Mobile Three-Dimensional Model for Assembly Site of Complex Product[D]. Xi'an, Northwestern Polytechnical University, 2014 (in Chinese) |

| [3] |

陈祥辉.大部件人工装配作业现场信息投影技术研究[D].上海: 华中科技大学, 2016 CHEN Xianghui. Research of Satellite Assembly Induced System Based on Augmented Reality[D]. Shanghai, Huazhong University of Science and Technology, 2016 (in Chinese) |

| [4] | TOMBARI F, FRANCHI A, STEFANO L D. BOLD Features to Detect Textureless Objects[C]//IEEE International Conference on Computer Vision Sydney, 2014: 1265-1272 |

| [5] | DAMEN D, BUNNUN P, CALWAY A, et al. Real-Time Learning and Detection of 3D Textureless Objects: a Scalable Approach[C]//The British Machine Vision Conference, Guildford, 2012: 1-12 |

| [6] | WANG G, WANG B, ZHONG F, et al. Global Optimal Searching for Textureless 3D Object Tracking[J]. Visual Computer, 2015, 31(6/7/8): 979-988. |

| [7] | WANG Y, ZHANG S S, YANG S, et al. A LINE-MOD-Based Markerless Tracking Approach for AR Applications[J]. International Journal of Advanced Manufacturing Technology, 2017, 89(5/6/7/8): 1699-1707. |

| [8] |

徐迟.增强现实中的三维物体注册方法及其应用研究[D].上海: 华中科技大学, 2011 XU Chi. Research on the 3D Objeet Registration Method in Augmented Reality and Its Application[D]. Shanghai, Huazhong University of Science and Technology, 2011 (in Chinese) |

| [9] | ENGEL J, STVCKLER J, CREMERS D. Large-Scale Direct SLAM with Stereo Cameras[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems, Hamburg, 2015: 1935-1942 |

| [10] | MUR-ARTAL R, MONTIEL J M M, TARDÍS J D. ORB-SLAM:a Versatile and Accurate Monocular SLAM System[J]. IEEE Trans on Robotics, 2015, 31(5): 1147-1163. DOI:10.1109/TRO.2015.2463671 |

| [11] |

付梦印, 吕宪伟, 刘彤, 等. 基于RGB-D数据的实时SLAM算法[J]. 机器人, 2015, 37(6): 683-692.

FU Mengyin, LÜ Xianwei, LIU Tong, et al. Real-time SLAM Algorithm Based on RGB-D Data[J]. Robot, 2015, 37(6): 683-692. (in Chinese) |

| [12] | RADKOWSKI R. Object Tracking with a Range Camera for Augmented Reality Assembly Assistance[J]. Journal of Computing and Information Science in Engineering, 2016, 16(1): 011004. DOI:10.1115/1.4031981 |

| [13] |

刘鑫辰, 傅慧源, 马华东. 基于RGB-D摄像头的实时手指跟踪注册与手势识别[J]. 计算机科学, 2014, 41(10): 50-52.

LIU Xinchen, FU Huiyuan, MA Huadong, et al. Real-time Fingertip Tracking and Gesture Recognition Using RGB-D Camera[J]. Computer Science, 2014, 41(10): 50-52. (in Chinese) DOI:10.11896/j.issn.1002-137X.2014.10.011 |

| [14] | MATSUO T, FUKUSHIMA N, ISHIBASHI Y. Weighted Joint Bilateral Filter with Slope Depth Compensation Filter for Depth Map Refinement[C]//International Conference on Computer Vision Theory and Applications, Berlin, 2015: 313-320 |

| [15] | BIAN J W, LIN W Y, MATSUSHITA Y, et al. GMS: Grid-Based Motion Statistics for Fast, Ultra-Robust Feature Correspondence[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition, Puerto Rico, 2017: 2828-2837 |

| [16] |

沈跃, 潘成凯, 刘慧, 等. 基于改进SIFT-ICP算法的Kinect植株点云配准方法[J]. 农业机械学报, 2017(12): 183-189.

SHEN Yue, PAN Chengkai, LIU Hui, et al. Method of Plant Point Cloud Registration Based on Kinect of Improved SIFT-ICP[J]. Transactions of the Chinese Society of Agricultural, 2017(12): 183-189. (in Chinese) DOI:10.6041/j.issn.1000-1298.2017.12.021 |

| [17] | HENRY P, KRAININ M, HERBST E, et al. RGB-D Mapping:Using Depth Cameras for Dense 3D Modeling of Indoor Environments[M]. Springer: Berlin Heidebery, 2014: 647-663. |

| [18] |

李同, 张奇志. 基于ORB词袋模型的SLAM回环检测研究[J]. 信息通信, 2017(10): 20-25.

LI Tong, ZHANG Qizhi. Research of SLAM Loop-Closure Based on ORB Bag of Words[J]. Information & Communications, 2017(10): 20-25. (in Chinese) DOI:10.3969/j.issn.1673-1131.2017.10.008 |

| [19] | NEWCOMBE R A, IZADI S, HILLIGES O, et al. Kinect Fusion: Real-Time Dense Surface Mapping and Tracking[C]//IEEE International Symposium on Mixed and Augmented Reality, Basel, 2011: 127-136 |

| [20] | WANG Y, ZHANG S S, YANG S, et al. Mechanical Assembly Assistance Using Markerless Augmented Reality System[J]. Assembly Automation, 2018, 38(1): 77-87. DOI:10.1108/AA-11-2016-152 |

| [21] |

徐迟, 李世其, 王峻峰, 等. 面向增强现实装配的虚实遮挡技术研究[J]. 机械设计与制造, 2009(12): 256-258.

XU Chi, LI Shiqi, WANG Junfeng, et al. Ocelusion Handling in Augmented Reality Based Virtuecl Assembly[J]. Machinery Oesign & Manufaeture, 2009(12): 256-258. (in Chinese) DOI:10.3969/j.issn.1001-3997.2009.12.105 |