图像配准是对有共同场景而在不同时刻或不同角度拍摄的2幅或多幅图像的处理。在许多领域诸如计算机视觉、图像预处理、电脑图像、病情检测、3D重构、环境监测、变化检测、图像融合、图像拼接和地图拼接中,图像配准都是非常基础和关键的技术。对图像配准的研究具有重要的理论意义和实际应用价值。

近年来,对配准算法的研究大致可分为2大类:基于区域的图像配准算法和基于特征的图像配准算法。前者主要是直接使用图像相同部分中原始的像素,通过寻找参考图像和待配准图像之间的最小距离,达到配准的效果,如梯度相关[1]、颜色直方图匹配[2-3]、互信息[4]以及轮廓等。后者则主要提取图像中对缩放、旋转、平移、照度等保持不变的特征,如Harris角点[5]、SIFT[6](scale invariant feature transform) 特征和SURF[7](speed-up robust feature) 等,通过相关矩阵等方法达到特征点匹配的效果。基于区域的方法在以光照强度或灰度强弱作为显著信息而不是局部的形状或者结构作为特征信息时,更受研究者们的欢迎,但是基于区域的方法因为计算量巨大、图像变形、光照变换等影响其准确性和实用性。基于局部特征的方法鲁棒性更强,可更好应用于具有复杂形变的图像之间及具有成像原理不同的图像之间。

局部不变特征在各个领域已成功得到广泛应用。很多局部不变特征都对平移、旋转、仿射变换、光照变化等因素保持稳定性。迄今为止,已经有大量的特征点检测算法,典型的特征检测子有Moravec在1997年提出的Moravec检测子[8],Harris提出的Harris角点、Hessian-Laplace[9]等,其中最具有代表性的是Lowe在2004年提出的SIFT特征点算法,该算法一举成为这一领域的佼佼者。其后,相继出现了很多基于SIFT特征点的图像配准算法,研究内容一般集中在2个方面:① 针对SIFT特征提取对算法的改进,如SURF、ORB (oriented brief)[10],A-SIFT (affine-SIFT)[11],CSIFT算法 (colored SIFT)[12]以及改进的SIFT算法[13-15]等,这些特征检测算法对光照变化和小的几何形变均具有较好的鲁棒性;② 特征点提取之后,研究特征点集之间的匹配,例如利用RANSAC算法剔除误匹配点。

虽然上述局部不变特征对局部形变、灰度差异、图像失真及噪声等具有很好的鲁棒性,但是局部不变特征计算复杂、数据量大,在匹配中会出现很多误匹配特征点。为解决上述误匹配问题,本文提出了一种简单有效的筛选正确匹配点的角度相对距离,剔除了粗匹配后对应关系中存在的错误关系。2015年马佳义提出了一种基于贝叶斯模型的LLT算法[16],在遥感图像配准方面取得了很好的效果,但经过实验,马佳义的算法在很多配准结果中,均出现了较多的误匹配结果。与之相比,本文提出的算法原理简单、适用性广,且正确率更高。

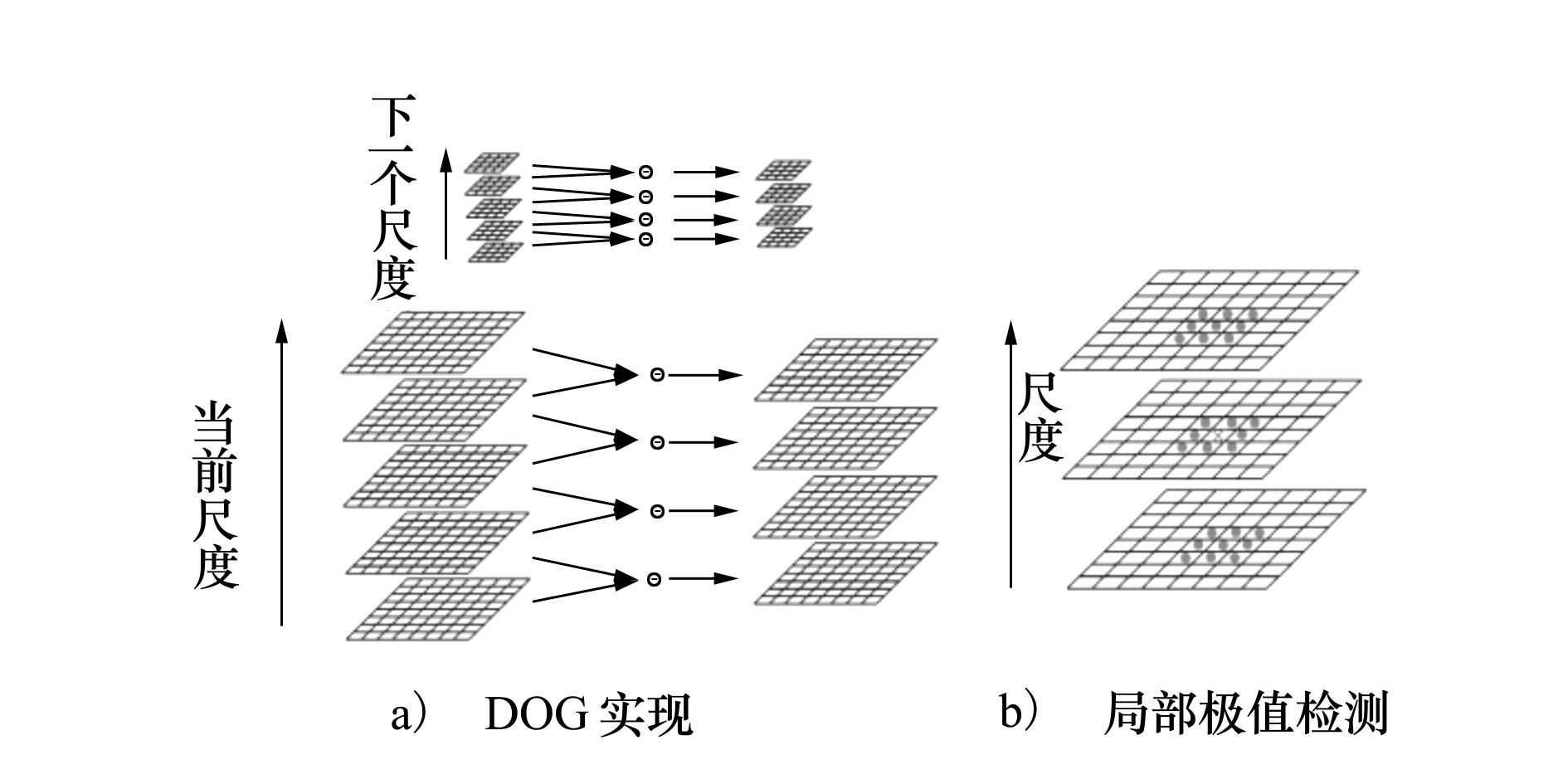

1 SIFT特征提取提取SIFT特征的大致过程是:将输入图像通过不同尺度的高斯核函数 (参见 (1) 式) 连续滤波和下采样,形成高斯金字塔图像,然后再对相邻尺度的2个高斯图像相减得到高斯差分 (difference of gaussian, DOG) 的多尺度空间表示。将样本点和它相邻的26个像素点进行比较,得到DOG图像中的极值点 (即关键点) 的位置和对应的尺度 (参见图 1);将关键点所在16×16邻域像素内梯度方向直方图最大值所对应的方向作为关键点方向;在此基础上,将邻域的16×16像素划为4×4共16个子区域,分别统计各个区域的8个梯度方向就可以得到SIFT的128维特征描述子。

|

| 图 1 DOG空间建立及极值点检测示意图 |

|

(1) |

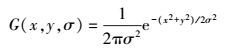

式中, σ代表了高斯正态分布的方差, (x, y) 是图像像素空间坐标。

2 基于角度相对距离的图像配准算法框架基于特征的图像配准算法, 主要通过提取图像中的显著特征进行计算, 该算法灵活, 执行速度快, 精度高。假设提取到的这些显著特征为特征点。在提取出特征点后, 图像配准的工作就简化为在特征点之间寻找对应关系的问题。通常, 基于特征的配准算法主要由以下4部分组成:① 提取参考图和待配准图的SIFT特征点; ② SIFT特征点匹配, 包括粗匹配和精匹配筛选正确匹配特征点; ③ 计算图像间的变换关系; ④ 图像重采样和插值。本文的重点研究内容, 在于第二步特征点匹配中正确匹配特征点的筛选。

特征点的提取和匹配, 是基于特征的图像配准算法的核心, 将直接影响配准的精度。首先, 从参考图像和待配准图像中提取出足够多的特征点, 特征点的提取方法必须具有尺度和旋转不变性, 采用SIFT特征正好能满足要求; 然后利用特征点之间的欧氏距离对特征点进行粗匹配; 再利用特征点的角度相对距离对粗匹配后的特征点进行精匹配, 最终得到正确匹配的特征点。

3 基于角度相对距离的特征点的匹配及筛选对于提取到的SIFT特征点和特征点描述符, 采用粗匹配和精匹配两步完成特征点正确匹配特征点的筛选。

3.1 基于欧式距离的特征点粗匹配设Pini和Qini是参考图和待配准图中提取到的SIFT特征向量集合, 其中Pini和Qini中各有M和N个特征点。假设对于Pini中的任何一个特征点pi, 在Qini中与pi特征向量的欧式距离最小的2个特征点为qj和qk, 对应的距离为dij和dik, 且dij<dik, 如果dij<dik*T, 则认为pi与qj为对应的匹配点对 (T是一个预定阈值), 通常取T=0.8。采用阈值的方法可以得到2个特征向量集合之间的粗匹配结果。此结果中可能存在一些错误匹配的特征点, 以往文献中通常采用RANSAC算法筛选出正确匹配特征点。而本文提出了一种基于角度相对距离的正确匹配特征点筛选算法, 用于实现对粗匹配结果的精确匹配, 其效果更好。

3.2 基于角度相对距离的特征点精匹配假设P和Q是参考图像和待配准图像中SIFT特征粗匹配后得到的特征集。其中P和Q中有L个特征点 (有S个正确的匹配点), 假设p1, p2, …, pm, (m<L) 是特征集P中的m个特征点, 且对应特征集Q中的特征点为q1, q2, …, qm, (m<L), 针对图像中存在的仿射变换, 虽然特征点之间的坐标关系存在着显著变化, 但是彼此有关联, 具有恒定的规律。在特征粗匹配的结果上, 通过计算参考图像和待配准图像各自对应特征之间的角度, 统计特征点在2幅图像中与其余特征点之间的角度关系, 可以判断该点是否为正确的匹配点。假设pi和qi是参考图和待配准图上对应的2个特征点, 那么, 彼此与剩下的L-1个特征点之间存在一个L-1维的角度关系矩阵Mpi和Mqi, 通过计算对应角度差异, 若小于角度误差参数e-angle, 该点的比重累加1, 最后选出其中部分最优的特征点作为精确匹配结果输出。

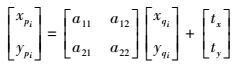

假设 (xpi, ypi) 和 (xqi, yqi) 分别对应特征集P和Q中对应的特征点对的坐标, 那么, 假设图像特征点坐标之间存在的相似变换和仿射变换关系为

|

(2) |

式中, [tx, ty]T为平移量,

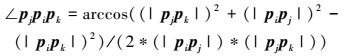

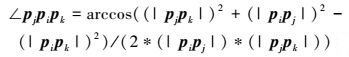

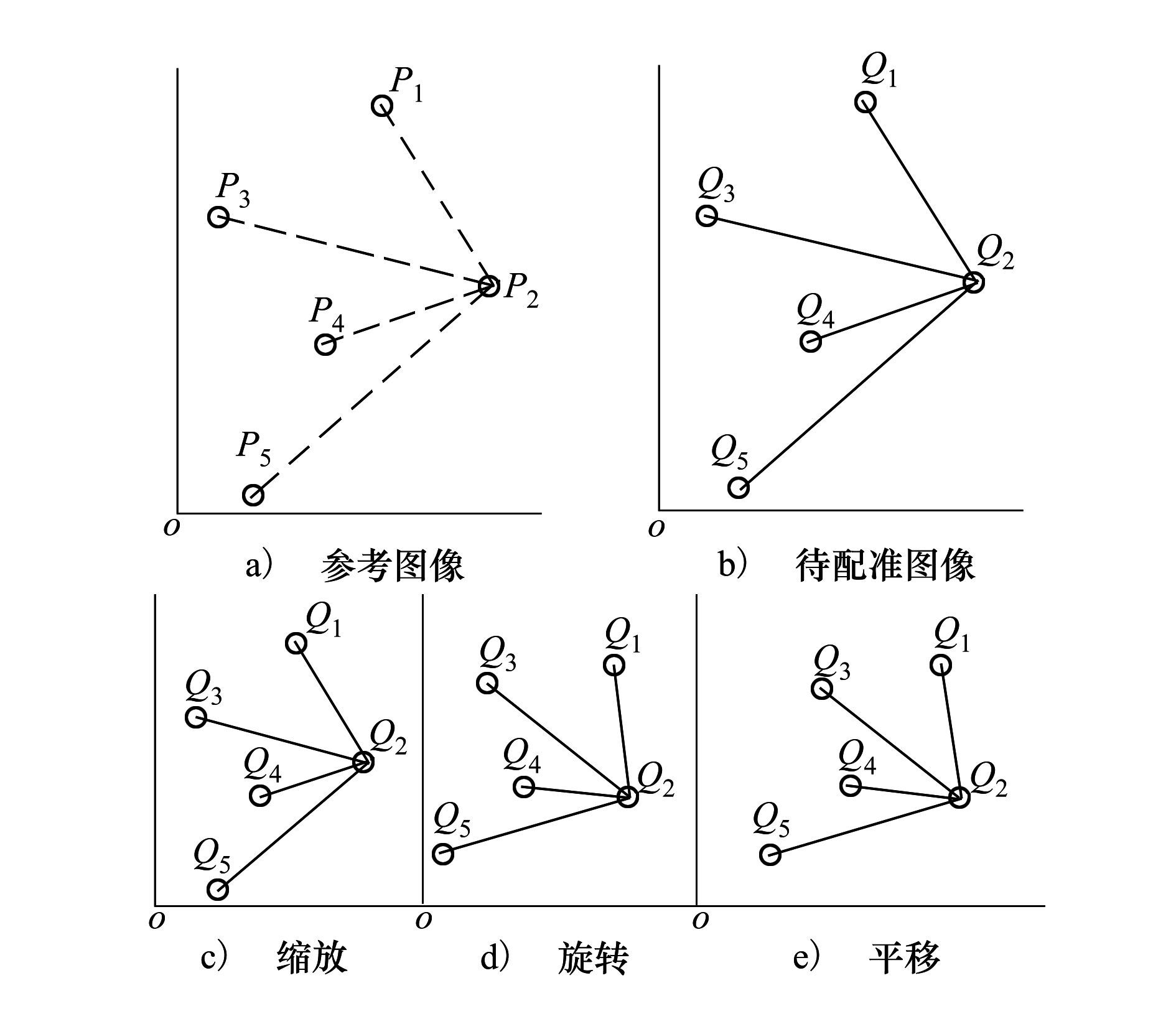

显然, 平面上任意三点pi、pj、pk之间的夹角为

|

(3) |

式中, |pipj|代表点pi、pj之间的距离。

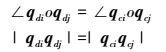

假设pi和qi是任意2个正确的对应特征点对, 那么 (xqi, yqi) 和 (xpi, ypi) 均满足 (2) 式。假设p1、p2、p3、p4、p5和q1、q2、q3、q4、q5为对应的5个特征点, 且所有的特征点坐标均满足 (2) 式。那么任意对应的三点连线的角度∠pjpipk和∠qjqiqk的计算过程如下

|

(4) |

|

(5) |

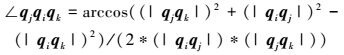

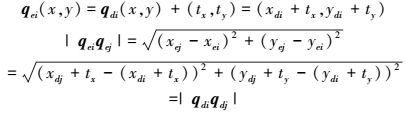

如图 2所示, 假设图 2a) 和图 2b) 是参考图像和待配准图像中, 对应的5对特征点, 且两者之间完全一致, 则∠pjpipk=∠qjqiqk。

|

| 图 2 图像相似变换 |

图 2c) 是在图 2b) 的基础上发生了缩放, 那么存在以下关系

|

(6) |

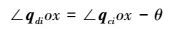

图 2d) 是在图 2c) 的基础上发生了旋转, 因此, 存在如下关系

|

(7) |

式中, o是坐标原点, x代表x轴正半轴, θ为旋转角度, 因此有

|

(8) |

图 2e) 是在图 2d) 的基础上发生了平移变换, 因此存在

|

(9) |

因此, 存在相似变换的参考图像和待配准图像中相关特征点间的角度将保持不变。除了上述的相似变换, 图像配准中还存在着微小的错切变化, 错切导致了前述的角度关系发生了变化。为了适应图像错切变换导致的角度变化, 角度误差参数 (e-angle) 实现了算法对于错切的适应。

前面揭示了2幅有着仿射变换差异的图像特征点之间存在着角度关联的关系。假若3个特征点之间存在一个误匹配点, 则有∠qdjqdiqdk≠∠qcjqciqck。如果图像中存在2个误匹配点, 则可能出现恰好满足∠qdjqdiqdk=∠qcjqciqck+e-angle的情况。但是, 在M个互相匹配的特征点对中, 1个误匹配点在某个特征点处可能存在∠qdjqdiqdk=∠qcjqciqck+e-angle的情况, 但是, 假设1幅大小为M×N的图像, 假设点qdi是1个正确的对应点, 而点qdj是1个错误点, 则点qdk使得∠qdjqdiqdk=∠qcjqciqck+e-angle的概率可近似为e-angle/360, 在一个有着L个特征 (有S个特征点对是正确的) 点的情况下, 使得满足S/2个角度符合上述标准的概率为 (e-angle/360)S/2, 在这样的情况下, 此概率通常很小, 基本可以忽略这种情况的出现。

4 实验结果及分析为验证本文所提出的特征点筛选算法的有效性, 用实际图像对该算法进行了配准实验, 所有实验均在Core (TM)2 Duo CPU E7500@2.93Ghz且内存为2GB的PC机的硬件环境下, 采用MATLAB2014a编程实现。

配准实验使用了15组图像, 其中包含了可见光图像、红外图像和遥感图像。第1、2、3、10、11、12、14组实验图像是可见光图像; 第8组实验为红外与可见光图像; 第4、5、6、7、9、13、15组实验图像为遥感、红外及多光谱图像。实验中使用SIFT特征点提取图像特征, 并利用欧式距离进行了粗匹配。表 1记录了LLT算法、RANSAC算法和本文算法在15组图像中精匹配的特征点数目, 图 3给出了部分精匹配结果。

| 序号 | 粗匹配 | LLT | RANSAC | 本文算法 |

| 1 | 307 | 259 | 253 | 263 |

| 2 | 2 070 | 1 505 | 775 | 1 507 |

| 3 | 3 154 | 2 169 | 1 582 | 2 186 |

| 4 | 928 | 843 | 777 | 871 |

| 5 | 218 | 214 | 189 | 214 |

| 6 | 582 | 180 | 178 | 189 |

| 7 | 272 | 111 | 108 | 113 |

| 8 | 59 | 46 | 39 | 41 |

| 9 | 52 | 14 | 22 | 25 |

| 10 | 116 | 106 | 91 | 94 |

| 11 | 35 | 29 | 29 | 29 |

| 12 | 30 | 27 | 28 | 28 |

| 13 | 16 | 15 | 15 | 15 |

| 14 | 70 | 60 | 40 | 44 |

| 15 | 37 | 24 | 26 | 26 |

|

| 图 3 部分实验精匹配结果 (圆圈为部分错误匹配结果) |

从表 1可以看到, 本文方法在多数情况下均可以比LLT算法和基于RANSAC算法得到更多的精匹配结果, 且在实验中, 本文方法精匹配结果更加准确, 这为图像配准和拼接处理提供了更多可靠的信息。在表 1中可以看到本文的算法在第8、第10和第14组图像中筛选出的正确匹配特征点数明显比LLT算法筛选出的正确匹配特征点数目少, 这并不表示本文方法结果不如LLT算法, 这是因为LLT算法在这几组实验图像中筛选出了错误匹配的特征点对, 而本文算法虽然在这几组图像中筛选的数目比LLT算法少, 但全部是正确的匹配点对。本文挑出了几组图像在3种方法中的精确匹配结果如图 3所示, 图像中圆圈里圈出了部分错误匹配特征点在参考图像和待配准图像中的位置。从图 3可以清楚看到在第8、第10和第14组图像的实验中, LLT算法筛选出了很多错误匹配的特征点对。

图像粗匹配过程中, 大多都存在许多误匹配点, 如果不对粗匹配进行错误点的剔除, 会造成后期图像变换存在误差。本文的特征点精确匹配算法十分依赖于角度误差参数 (e-angle) 的设定, 这里的实验e-angle一般设定为1~5, 这是一个比较合理的取值范围。随着参数e-angle的减小, 特征点个数也在减小, 但是, 特征点的匹配准确率在逐渐提高, e-angle设为5是一个较为理想的值。实验中, 从整体的实验出发, e-angle设定越小能更好地减小误匹配点, 却也会减少正确匹配的特征点个数。

从图 3中不难看出,由于待配准和参考图像之间存在很多灰度或者角度的差异,初始匹配包含不少的误匹配点,而LLT算法、基于RANSAC算法和本文的方法能从包含大量错误匹配点的初始数据中剔除错误匹配点,得到正确的特征匹配关系。和LLT算法和基于RANSAC的算法相比,本文方法原理简单,在具有平移、旋转、缩放的特征匹配中具有更高的准确率,且可以筛选出更多正确匹配的特征点。

5 结论本文提出了一种基于SIFT特征和角度相对距离的图像配准算法。此算法充分利用了图像正确匹配的特征点对之间存在的角度关系,进行特征点精确匹配,可以有效筛选出正确匹配点。该方法在特征点提取上,只需利用提取的SIFT特征,并不需要借用其他辅助信息,就可以实现特征点之间的精确匹配。本文算法不仅适用于普通图像,而且在近红外与可见光图像以及遥感图像中,均充分显现了良好的鲁棒性和适用性,在匹配特征点数目较少时,也具有良好的鲁棒性。当然,如果在SIFT特征全局匹配时无法找到正确的匹配点或正确的匹配点过少时,本文算法和LLT算法以及基于RANSAC算法均会出现无法正确筛选正确匹配点的情况。这时,就需要利用先验知识或其他方法完成初始的特征提取和初始匹配,这些都是后期值得继续深入研究的方向。

| [1] | Wei Y, Tao L. Efficient Histogram-Based Sliding Window[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, San Francisco, 2010:3003-3010 |

| [2] | Kagarlitsky S, Moses Y, Hel-Or Y. Piecewise-Consistent Color Mappings of Images Acquired under Various Conditions[C]//IEEE International Conference on Computer Vision. Kyoto, 2009:2311-2318 |

| [3] | Zhang X Q, Men T, Liu C, Yang J. Infrared and Visible Images Registration Using BEMD and MI[C]//IEEE International Conference on Computer Science and Information Technology. Chengdu, 2010:644-647 |

| [4] | Mahesh, Subramanyam M V. Automatic Feature Based Image Registration Using SIFT Algorithm[C]//International Conference on Computing Communication and Networking Technologies. India, 2012:1-5 |

| [5] | Harris C G, Stephens M J. A Combined Corner and Edge Detector[J]. Alvey Vision Conference, 1988(3): 147–151. |

| [6] | Lowe D G. Distinctive Image Features from Scale-Invariant Keypoints[J]. International Journal of Computer Vision, 2004, 60(2): 91–110. DOI:10.1023/B:VISI.0000029664.99615.94 |

| [7] | Bay H. SURF:Speeded-Up Robust Features[C]//European Conference on Computer Vision, Graz, 2006:404-417 |

| [8] | Moravec H P. Rover Visual Obstacle Avoidance[C]//International Joint Conference on Artificial Intelligence, Vancouver, 1981:785-790 |

| [9] | Mikolajczyk K, Schmid C. Indexing Based on Scale Invariant Interest Points[C]//IEEE International Conference on Computer Vision. Vancouver, Canada, 2001:525-531 |

| [10] | Rublee E, Rabaud V, Konolige K G, Bradski J R. ORB:an Efficient Alternative to SIFT or SURF[C]//IEEE International Conference on Computer Vision. Barcelona, Spain, 2011:2564-2571 |

| [11] | Morel J M, Yu G. ASIFT:A New Framework for Fully Affine Invariant Image Comparison[J]. SIAM Journal on Imaging Sciences, 2009, 2(2): 438–469. DOI:10.1137/080732730 |

| [12] | Abdel-Hakim A E, Farag A A. CSIFT:A SIFT Descriptor with Color Invariant Characteristics[C]//IEEE Conference on Computer Vision and Pattern Recognition. New York, 2006:1978-1983 |

| [13] | Amintoosi M, Fathy M, Mozayani N. A Fast Image Registration Approach Based on SIFT Key-Points Applied to Super-Resolution[J]. The Imaging Science Journal, 2012, 60(4): 185–201. DOI:10.1179/1743131X11Y.0000000015 |

| [14] | Vinividyadharan, Subusurendran, et al. Automatic Image Registration Using SIFT-NCC[J]. Ijca Special Issue on Advanced Computing and Communication Technologies for Hpc Applications, 2012, ACCTHPCA(4): 29–32. |

| [15] | Yang K W, Chen T H, Xing S X, et al. Infrared and Visible Image Registration Base on SIFT Features[C]//IEEE International Conference on Remote Sensing. Hangzhou, 2010:383-389 |

| [16] | Ma J, Zhou H, Zhao J, et al. Robust Feature Matching for Remote Sensing Image Registration via Locally Linear Transforming[J]. IEEE Trans on Geoscience and Remote Sensing, 2015, 53(12): 6469–6481. DOI:10.1109/TGRS.2015.2441954 |